Nvidia NIM & Blueprint: Aktuelle KI-Modelle einfach auf RTX AI-PCs ausführen [Anzeige]

![Nvidia NIM & Blueprint: Aktuelle KI-Modelle einfach auf RTX AI-PCs ausführen [Anzeige]](https://pics.computerbase.de/1/1/8/4/7/3-5fc0c7321d87877e/article-1280x720.7d1db622.jpg)

Wer einen RTX AI-PC sein Eigen nennt, hat ein mächtiges KI-Werkzeug in der Hand: Für DLSS in Spielen, RTX Broadcast beim Streaming oder zum Beschleunigen von KI- und Kreativ-Workflows in namhaften Apps. Kommen Nvidia NIM und Blueprint ins Spiel, lassen sich auch aktuelle KI-Modelle für neue innovative Anwendungen einfach nutzen.

NIM und Blueprint – was ist das eigentlich?

Direkt zu Beginn stellt sich allerdings noch einmal die Frage: Nvidia NIM und Blueprint - schon oft gehört, aber was ist das eigentlich? Um das einfach zu erklären, zuerst noch einmal einen Schritt zurück.

Ein Schritt zurück: Inferencing

KI-Modelle, ganz gleich welcher Art, müssen konzeptionell entwickelt und anschließend mit Daten trainiert werden („Training“). Mit trainierten Modellen kann dann wiederum gearbeitet werden. Diese Arbeit mit trainierten KI-Modellen nennt man „Inferencing“. Für das Inferencing bedarf es also:

- Eines trainierten Modells

- Einer Möglichkeit mit dem Modell zu interagieren

- Leistungsfähige Hardware um das Modell auszuführen

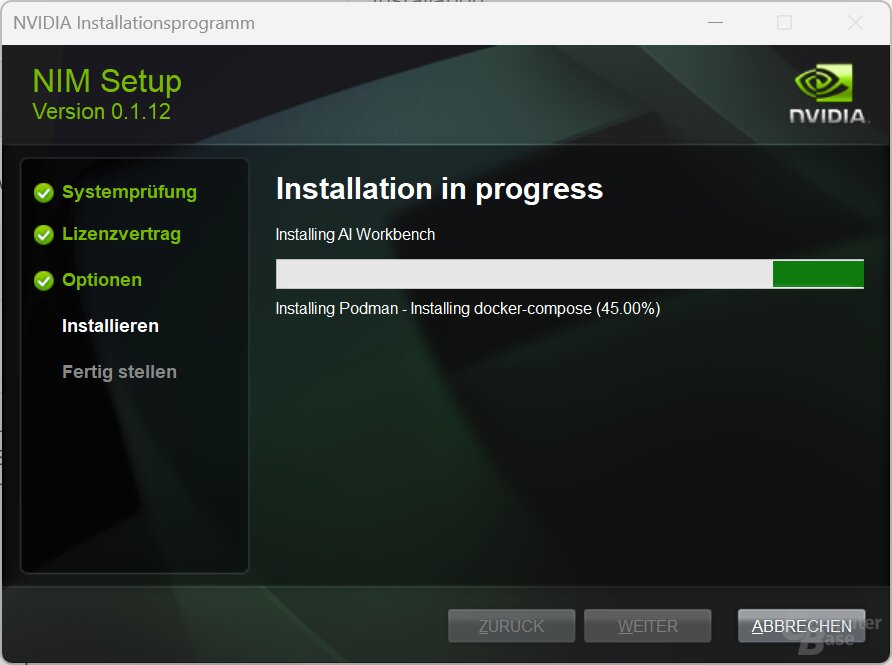

Nvidia NIM verständlich erklärt

Mit den Nvidia Inferencing Microservices (NIM) unterstützt Nvidia Unternehmen, Forschungseinrichtungen, Entwickler, Kreative und Privatpersonen sowohl bei der Bereitstellung als auch bei der Nutzung und Berechnung von KI-Modellen zum Inferencing.

NIM bietet dafür über 240 trainierte KI-Modelle aus sieben Schwerpunktbereichen an – von Nvidia und von Drittentwicklern. Sie können inklusive der erforderlichen Laufzeitkomponenten als Software-Pakete in Containern mit Enterprise-Qualität bezogen und auf der bevorzugten eigenen Infrastruktur gehostet werden: In der Cloud, im Rechenzentrum, auf Workstations oder Notebooks und PCs – was möglich ist, hängt vom jeweiligen NIM ab. Aktuell werden die folgenden Bereiche abgedeckt:

- Large Language Models (z.B. llama, Mistral, Gemma)

- Retrieval Models (z.B. llama, BAAI)

- Visual Models (Flux.1, Stable Diffusion)

- Multimodal Models (z.B. llama, phi)

- Healthcare Models (z.B. esmfold, openfold2, Vista3D)

- Route Optimization Models (cuOpt)

- Climate Simulation Models (corrdiff, fourcastnet)

Neben dem trainierten Modell und der notwendigen Laufzeitumgebung bieten NIMs darüber hinaus standardisierte APIs, mit denen auf die Modelle zugegriffen werden kann. Last but not least sind NIMs für GPU-beschleunigte Ausführung auf Nvidias KI-Beschleunigern (GeForce RTX, Nvidia RTX (Pro), Hopper, Blackwell etc.) optimiert worden. Ein NIM bietet also alles, was es zum Inferencing bedarf:

- Ein trainiertes KI-Modelle aus sieben Themenschwerpunkten

- Standardisierte APIs

- Optimierte Engines

Ein konkretes Beispiel ist das NIM FLUX.1-dev. Es bringt alles mit, um das generative KI-Bildgenerierungs-Modell des deutschen Entwicklers Black Forest Labs GPU-beschleunigt auf einem RTX AI-PC auszuführen.

Und wie passen jetzt Nvidia NIM und Blueprint zusammen?

Nvidia Blueprint verständlich erklärt

Nvidia Blueprints setzen auf Nvidia NIM auf. Ein Blueprint (eine Blaupause) ist ein Referenzbeispiel, das sich eines oder mehrere Nvidia NIM bedient um auf dieser Basis eine ganz neue innovative KI-Anwendung für einen bestimmten Zweck zu kreieren.

| Nvidia NIM | Nvidia Blueprint | |

|---|---|---|

| Zweck | Einfache Bereitstellung von KI-Modellen | Entwicklung kompletter KI-Workflows |

| Inhalt | KI-Modelle, Laufzeitumgebungen, APIs und optimierte Engines | Beispielprojekte mit Code und Deployment |

| NIM × Blueprint | NIM stellen KI-Modelle für Blueprints bereit | |

Ein Blueprint mit NIM im Detail

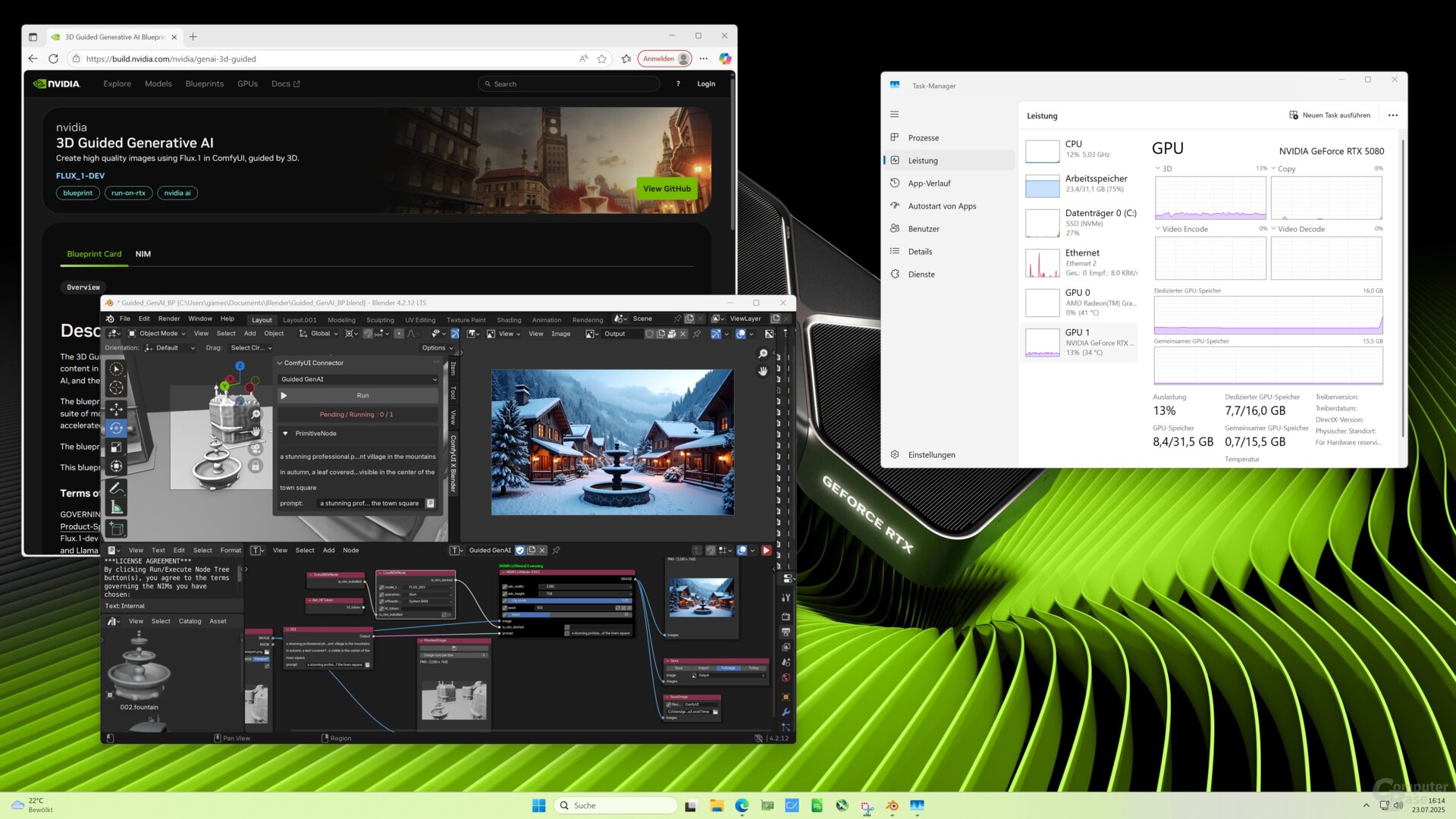

Ein sehr anschaulicher Blueprint mit integriertem NIM ist „3D Guided Generative AI“.

3D Guided Generative AI

Der Blueprint setzt auf den NIM FLUX.1-dev auf und räumt dabei gezielt eine Schwäche textbasierter Bild-Generierungs-Modelle aus. Denn so leistungsfähig Modelle wie Flux.1 auch sind, das Resultat entspricht trotz komplexer Texteingabe (Prompts) häufig nicht dem gewünschten Resultat. Mehr Kontrolle respektive Modelleingaben wäre besser. Sie alle in Textform zur Verfügung zu stellen, ist allerdings nicht praktikabel.

Der Blueprint zeigt, wie mehr Kontrolle auf ganz anderem Wege möglich ist. Dafür erhält das auf lokaler Nvidia-Hardware ausgeführte Flux1.-Modell nicht nur die Texteingabe des Anwenders als Vorlage. Über ComfyUI wird der KI darüber hinaus eine Rendervorlage aus Blender zur Orientierung gegeben – eine grobe Skizze reicht aus. Das folgende Video vermittelt anhand eines „Dorfes“, zu dessen Komposition Flux.1 anhand einfacher 3D-Modelle zusätzliche Informationen vorliegen, einen guten Überblick.

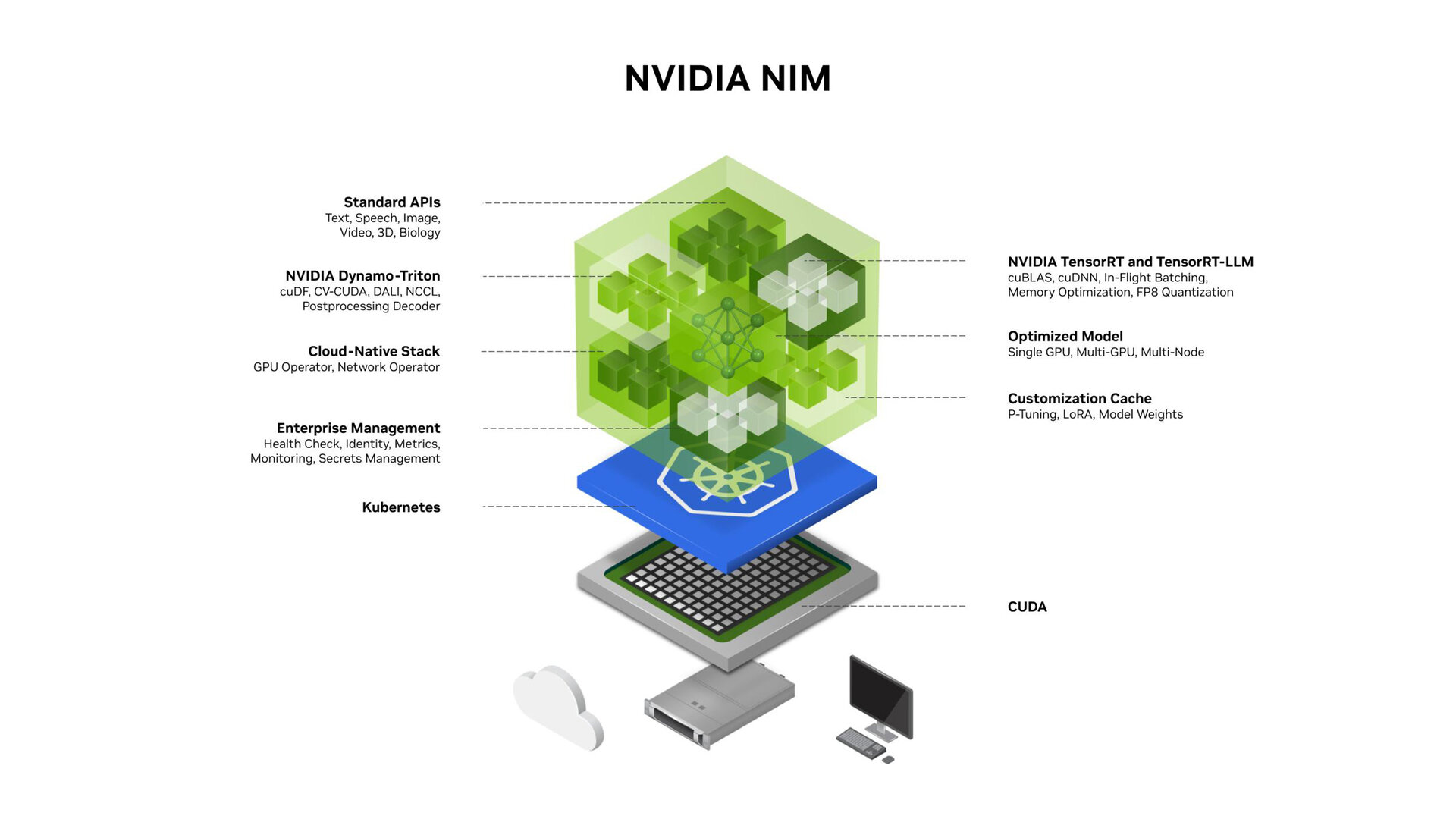

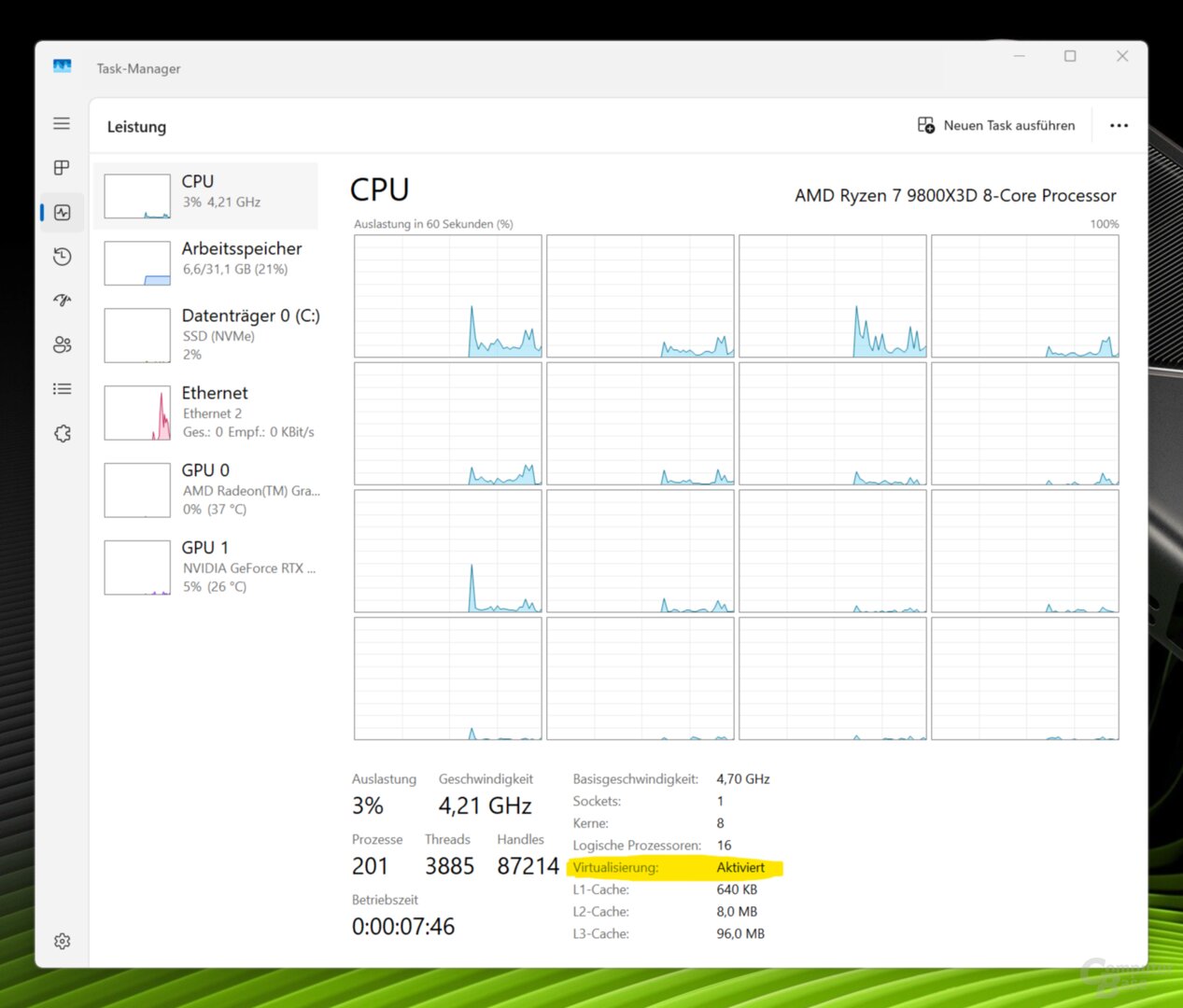

Wer den Blueprint 3D Guided Generative AI auf dem eigenen Rechner mit kompatibler Nvidia-Hardware zu nicht-kommerziellen Zwecken ausprobieren oder gar nutzen möchte, kann das auf einem System mit Windows 11 einfach tun.

Systemvoraussetzungen

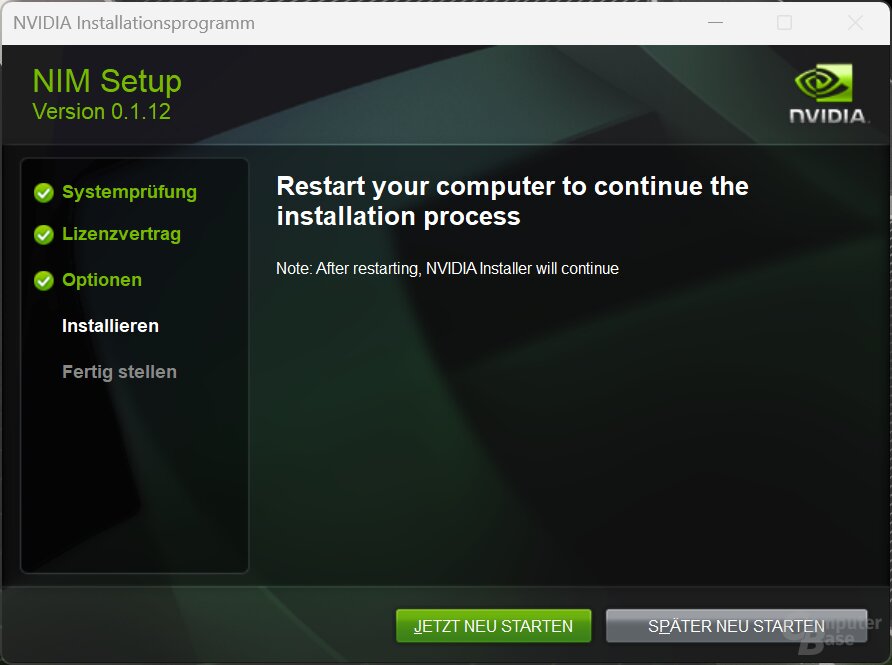

Der Blueprint ist über das Windows Subsystem for Linux (WSL 2) lauffähig. Wie es für das Deployment von NIM eingerichtet wird, erklärt Nvidia ausführlich online. Es gibt auch einen Installer. Wichtig: Auf dem Rechner muss Virtualisierung aktiv sein:

Nvidia empfiehlt für den konkreten Blueprint einen RTX AI-PC mit mindestens 48 GB. Denn quantifiziert und ausgeführt wird das Modell mittels Nvidia TensorRT auf kompatiblen GPUs. Aktuell werden die folgenden GPUs unterstützt. Weitere sollen aber folgen.

- Nvidia GeForce RTX 5090

- Nvidia GeForce RTX 5080

- Nvidia GeForce RTX 4090

- Nvidia GeForce RTX 4080

- Nvidia GeForce RTX 4090 Laptop GPU

- Nvidia RTX 6000 Lovelace Generation

Für die Ausführung des Beispiels kam ein RTX AI-PC mit Nvidia GeForce RTX 5080 zum Einsatz.

Den Blueprints einrichten

Erfüllt das System die Voraussetzungen, kann der Blueprint eingerichtet werden. Neben dem NIM Flux.1-dev benötigt werden das kostenlose Render-Tool Blender, ComfyUI sowie ComfyUI Blender AI Node – beides ist unter Lizenz GPL-3.0 ebenfalls frei verfügbar und im Installationsprozess mit inbegriffen.

Für den gesamten Einrichtungsprozess des Blueprints stellt Nvidia ebenfalls eine umfassende, bebilderte Schritt-für-Schritt-Anleitung zur Verfügung.

Zu Beginn richtet der NIM Prerequisite Installer das System für Nvidia NIM ein. Weitere Schritte sind in der Kommandozeile vorzunehmen, was anhand der guten Anleitung aber ebenfalls kein Problem darstellt. Zum Abschluss wird ComfyUI in Blender konfiguriert.

Mit dem Blueprint arbeiten

Der Blueprint kommt mit einer Projektdatei, in der die neuen Möglichkeiten zum erweiterten Prompten in Flux.1 direkt getestet werden können.

Im Blender-Viewport sind einige Gebäude und ein Brunnen als einfache 3D-Modelle hinterlegt. Der Standard-Prompt lautet „a stunning professional photo of a quaint village in the mountains in winter, a snow covered fountain is visible in the center of the town square“.

Flux.1 kann nun auf drei Arten zum Rendern einer neuen Szene auf der Nvidia GPU bewegt werden:

- Der Text-Prompt wird angepasst

- Die Perspektive auf die Szene in Blender wird verändert

- Die Szene in Blender wird verändert

Nach jeder Anpassung kann das Modell auf der GPU im RTX AI-PC neu berechnet werden: Im Beispiel eine GeForce RTX 5080. Nach wenigen Sekunden ist das Resultat sowohl in Blender als auch im zuvor über ConfiUI definierten Ordner abgelegt – ohne über die Cloud zu gehen.

Wird die Szene angepasst, indem der Brunnen durch das 3D-Modell eines Bootes ersetzt wird, und als Prompt „eine Szene aus Venedig“ mitgegeben, fällt das Resultat natürlich ganz anders aus. Das Boot steht allerdings dort, wo es in der Vorlage positioniert wurde, und auch die dort mit 3D-Modellen von Häusern abgebildete Gasse findet sich auf dem Gen-AI-Bild wieder. Dank der mit einer 3D-Vorlage geleiteten Generativen Bild-KI entspricht das Ergebnis den Erwartungen viel eher.

Blueprints für AI-Agenten für Enterprise

Neben diesem auch auf dem heimischen RTX AI-PC anschaulich nachvollziehbaren Blueprint stellt Nvidia über 30 weitere Blueprints online zur Verfügung. Über den Filter „Run-on-RTX“ lassen sich dabei alle Vorlagen herausfiltern, die auch auf einer RTX-Grafikkarte lauffähig sind. Andere benötigen High-Performance-Computing-Hardware (HPC) wie die Hopper- (H100, H200) oder Blackwell-Beschleuniger (B100, (G)B200, GB300).

Weitere Blaupausen gibt es zum Beispiel zum Designen von Proteinen (Evo 2 Protein Design), zum Erkennen von Kreditkartenbetrug (Financial Fraud Detection) oder zum Erstellen von Podcasts auf Basis von PDFs (PDF to Podcast). Für Unternehmen besonders interessant ist auch der Blueprint für einen virtuellen Assistenten (Build an AI Virtual Assistant).

Am Ende sind aber auch diese umfassenden Blueprints nur ein Bruchteil dessen, was auf Basis der über 240 NIMs auf Nvidia-Plattformen in der Cloud, dem Rechenzentrum, Workstations oder RTX AI-PCs und Notebooks möglich ist.

Leistungsstarke RTX AI-PCs bei Memory PC

Leistungsstarke RTX AI-PCs für Nvidia NIM und Blueprint gibt es beispielsweise bei Memory PC.

Memory PC ist ein führender Hersteller von anpassbaren PCs mit über 15 Jahren Erfahrung und Sitz in Friesland. Über den umfangreichen Online-Konfigurator können PCs individuell auf die eigenen Wünsche angepasst werden, jeder PC durchläuft vor der Auslieferung umfangreiche Testroutinen. Memory PC gewährt standardmäßig 2 Jahre Garantie (auf 3 Jahre erweiterbar).