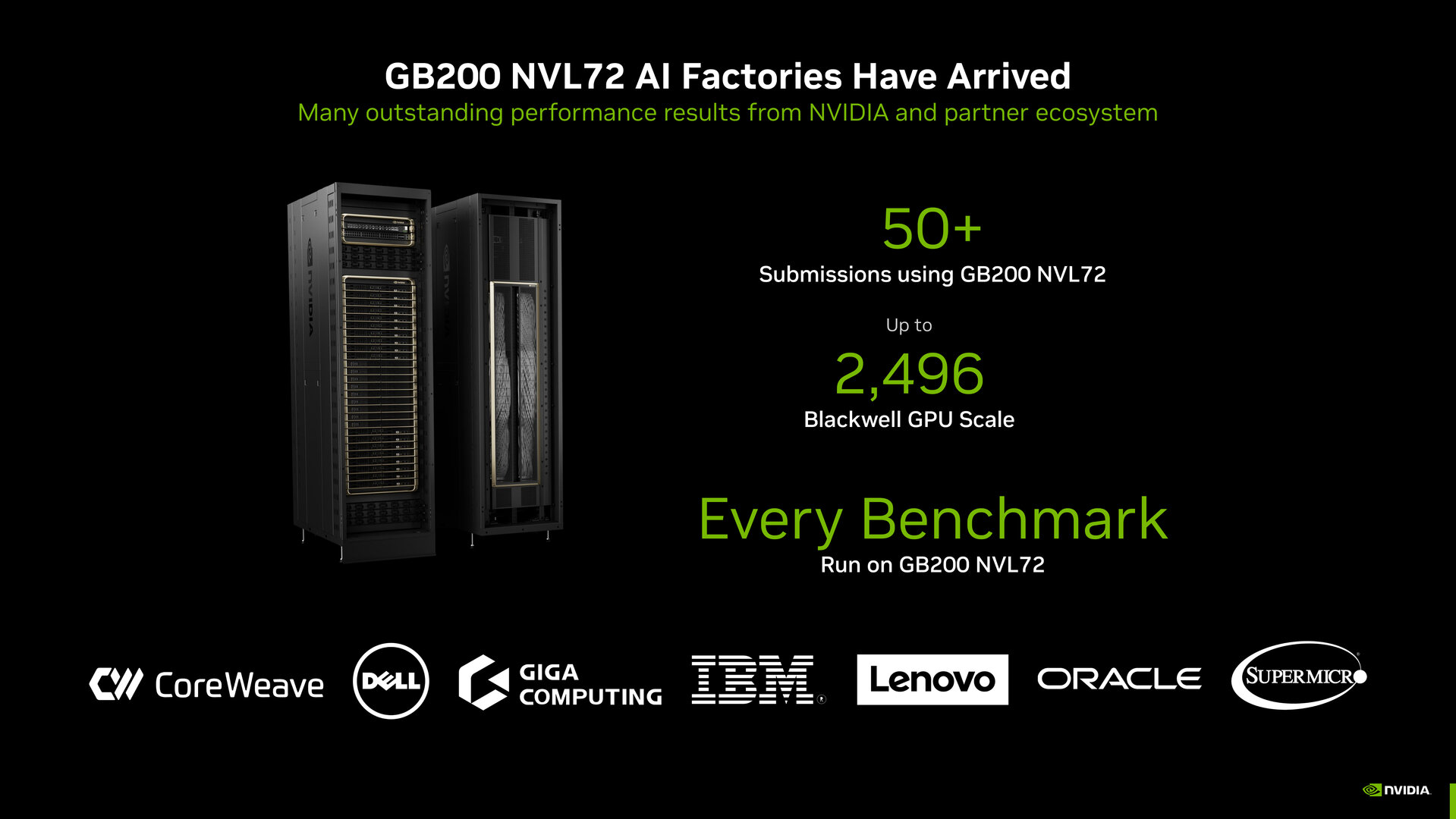

MLPerf Training 5.0: Nvidia setzt sich mit GB200 NVL72 an die Spitze

In der zwölften Runde des MLPerf Training Benchmarks seit der Einführung 2018 setzt sich Nvidia mit GB200 NVL72 an die Spitze aller Messungen und stellt in den meisten Kategorien neue Rekorde auf. Dazu gehörte diesmal auch das LLM Pre-Training von Llama 3.1 405B. Auch die Effizienz und Skalierung von GB200 zeigt Nvidia auf.

MLCommons ist das gemeinnützige Konsortium hinter den MLPerf Benchmarks, die halbjährlich für das Training und Inferencing veröffentlicht werden. Dahinter stehen über 125 Mitglieder wie AMD, Arm, Google, Huawei, Intel, Nvidia, Qualcomm, Samsung und viele weitere, die vor der Veröffentlichung der Ergebnisse auch für das Peer Review zuständig sind, sodass von standardisierten Benchmarks von KI-Systemen, deren Ergebnisse von gleichrangigen Mitgliedern überprüft wurden, gesprochen werden kann.

Nvidia stellt in fünf Benchmarks Rekorde auf

In der aktuellen Runde stand mit MLPerf Training v5.0 das Training verschiedener KI-Modelle im Fokus der Benchmarks. Der Redaktion lagen zum heutigen Embargo um 17 Uhr deutscher Zeit ausschließlich erste Ergebnisse von Nvidia vor, weitere anderer Hersteller dürften jetzt mit der Veröffentlichung bekannt werden. Nvidia stellt in dem eigenen Pressematerial die neuen Rekordwerte des KI-Systems GB200 NVL72 in fünf Benchmarks sowie die Leistungssteigerungen gegenüber Hopper, die Leistung pro Dollar und die Skalierung der Blackwell-Lösung in den Fokus. Nvidia war laut eigener Aussage zudem das einzige beteiligte Unternehmen, das in allen MLPerf Training 5.0 Benchmarks Ergebnisse eingereicht hat.

Llama 3.1 405B löst GPT-3 ab

Neu hinzu kam mit Beschluss vom 5. Mai diesmal das LLM Pre-Training von Llama 3.1 405B mit 405 Milliarden Parametern und ersetzt damit GPT-3 mit 175 Milliarden Parametern. Das Pre-Training beschreibt die initiale Phase des Trainings auf Basis großer Datensätze. Das können zum Beispiel Milliarden von Büchern oder Webseiten sein. Das Modell lernt dabei Fakten, Grammatik, Denkmuster und Kontext. Im Anschluss erfolgt das Feintuning des Sprachmodells für spezifische Aufgaben.

Das LLM Pre-Training von Llama 3.1 405B konnte Nvidia mit einem Aufbau aus mehreren GB200 NVL72 und insgesamt 512 GPUs in der 2,2-fachen Geschwindigkeit, also 120 Prozent schneller im Vergleich zu einem System mit 512 H100-GPUs der Hopper-Generation absolvieren. Alle Leistungswerte beziehen sich stets auf ISO-GPU, also dieselbe Anzahl von GPUs beider Generationen. 21 Minuten benötigte Nvidia für das LLM Pre-Training von Llama 3.1 405B mit GB200 NVL72.

Einen größeren Sprung von 150 Prozent im Vergleich zu acht H100-GPUs verzeichnete Nvidia beim Feintuning von Llama 2 70B LoRA (Low-Rank Adaptation: eine Methode, um große KI-Modelle effizient anzupassen, ohne das gesamte Modell neu zu trainieren) mit 8 Blackwell-GPUs in einem DGX B200, hier demnach nicht mit GB200 NVL72. Eine Steigerung von 160 Prozent gegenüber Hopper meldet Nvidia für das Text-zu-Bild-Modell Stable Diffusion v2.

30 bis 55 Prozent mehr Leistung pro Dollar

Die Trainingsleistung pro Dollar rückt Nvidia ebenso in den Fokus („The more you buy, the more you save“), auch wenn es sich dabei nicht um eine primäre Metrik des MLPerf Training 5.0 Benchmarks handelt. Demnach bekomme man mit Blackwell 30 Prozent mehr Leistung pro Dollar in Llama 3.1 405B, 45 Prozent mehr bei Llama 2 70B LoRA und 55 Prozent mehr bei Stable Diffusion v2.

Nvidia demonstriert 90 Prozent Skalierungseffizienz

Ebenfalls keine primäre Metrik von MLPerf Training 5.0 ist die Skalierung von KI-Systemen, die für Anbieter wie Nvidia aber von großer Bedeutung ist. Denn damit kann das Unternehmen die Vorteile von NVLink und Ethernet-Lösungen wie Quantum-2 InfiniBand, ConnectX sowie Spectrum-X und davon abgeleitet neben der Scale-up- auch die Scale-out-Leistung riesiger GPU-Cluster in den sogenannten AI-Fabriken aufzeigen.

In gemeinsam von CoreWeave und IBM eingereichten Ergebnissen mit GB200 NVL72 nennt Nvidia eine Skaleriungseffizienz von 90 Prozent von 512 auf 2.496 GPUs.

ComputerBase hat Informationen zu diesem Artikel von Nvidia unter NDA erhalten. Die einzige Vorgabe war der frühestmögliche Veröffentlichungszeitpunkt.