Spectrum-XGS Ethernet: Nvidia will AI-Rechenzentren global besser vernetzen

Nvidia will AI-Rechenzentren über die Grenzen von Gebäudekomplexen, Städten, Nationen und Kontinenten hinaus besser miteinander vernetzen. Dafür erweitert das Unternehmen die eigene Ethernet-Plattform Spectrum-X unter der Bezeichnung Spectrum-XGS (Giga-Scale) um neue Algorithmen für eine effizientere Kommunikation.

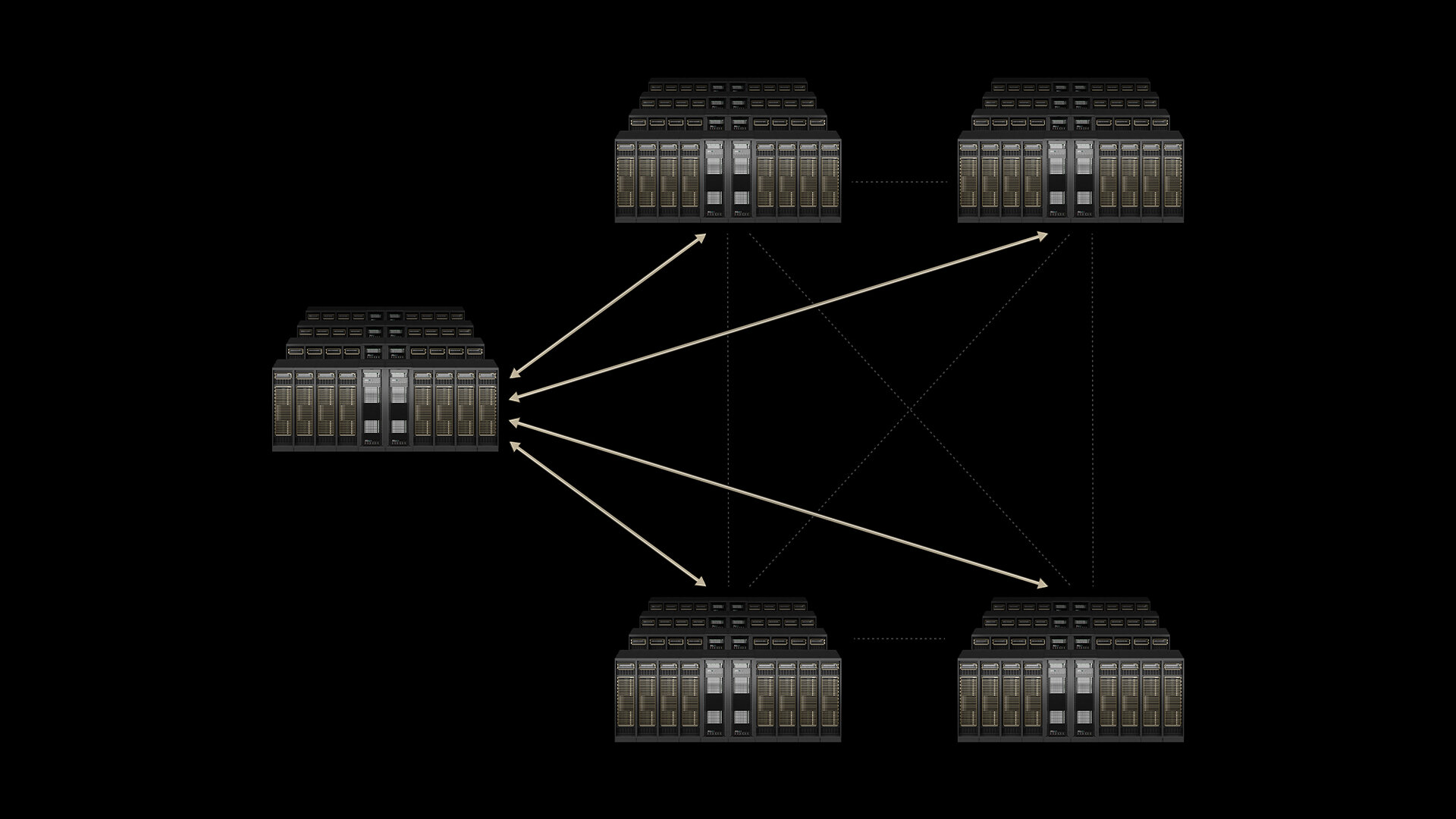

Scale-Up, Scale-Out, Scale-Across

Auf den Scale-Up innerhalb des Racks und den Scale-Out innerhalb des Rechenzentrums lässt Nvidia zur Hot-Chips-Konferenz den „Scale-Across“ über die Grenzen des Gebäudes hinaus folgen. Hintergrund der Entwicklung sind Nvidia zufolge die Einschränkungen, die je nach Standort hinsichtlich Kapazität und Energiebedarf beachtet werden müssen. Mancher Standort könne ab einem gewissen Punkt schlichtweg nicht weiter expandieren. Hier soll Spectrum-XGS Ethernet weiterhelfen.

Spectrum-X ist Nvidias Ethernet-Plattform, die unter anderem Switches und sogenannte SuperNICs umfasst. Mit den Switches der SN5000-Serie und den ConnectX-8-Netzwerkadaptern ist Nvidia bei Port-Geschwindigkeiten von 800 Gbit/s angekommen.

Spectrum-XGS soll Datacenter besser vernetzen

Spectrum-XGS, wobei das „GS“ im Namen für „Giga-Scale“ steht, stellt eine Erweiterung der Plattform dar, es handelt sich aber nicht um neue Hardware, wie Nvidia im Vorabgespräch zur Konferenz erläuterte. Vielmehr hat das Unternehmen eine Reihe neuer Algorithmen entwickelt, die das Netzwerkverhalten automatisch an die Entfernung unter den Rechenzentren anpassen sollen. Die globale Vernetzung weit verteilter Rechenzentren ist selbstredend nicht erst seit der Einführung von Spectrum-XGS möglich, damit soll der Prozess aber besser vonstatten gehen.

Mit Spectrum-XGS führt Nvidia eine automatisch regulierte Stausteuerung, präzises Latenz-Management und Ende-zu-Ende-Telemetrie ein. Die Multi-GPU- und Multi-Node-Kommunikation über das Nvidia Collective Communications Library (NCCL) habe man durch den Einsatz von Spectrum-XGS um 90 Prozent beschleunigen können.

CoreWeave setzt auf Spectrum-XGS

Betreiber von AI-Rechenzentren sollen damit über weitere Entfernungen eine „einzelne“ KI-Fabrik aufbauen können, obwohl es sich tatsächlich um verteilte Standorte handelt. Als erstes Unternehmen will der im April 2023 mit 100 Millionen US-Dollar von Nvidia geförderte Hyperscaler CoreWeave auf Spectrum-XGS setzen. „Mit Spectrum-XGS können wir unsere Datacenter zu einem vereinigten Supercomputer verbinden“, sagte Mitgründer und CTO Peter Salanki. CoreWeave betreibt derzeit insgesamt über 30 Rechenzentren unter anderem in den USA und Europa.

ComputerBase hat Informationen zu diesem Artikel von Nvidia unter NDA erhalten. Die einzige Vorgabe war der frühestmögliche Veröffentlichungszeitpunkt.

- DGX Spark: Nvidia gibt Einblick in die Technik des GB10

- (G)B300 vs. (G)B200: Blackwell Ultra nimmt Steroide und beherrscht PCIe 6.0

- Hot Chips 2025: Intel erläutert Clearwater Forest mit 288 Kernen und 17 Chiplets

- Spectrum-XGS Ethernet: Nvidia will AI-Rechenzentren global besser vernetzen