CDLABSRadonP... schrieb:

Leider ja, wurde gestern direkt aufgelöst:

Wobei sie ja gesagt haben, dass die größeren hätten bringen können. Auf AMD sind sie leider nicht eingegangen, weder auf die rx7800M noch die rx90x0. Man hätte halt das Gehäuse vergrößern müssen und ich kann da leider nicht zustimmen: Es wäre absolut kein Drama, wenn das GPU-Modul das Notebook ein Stück aufbockt. Ehrlich gesagt steht mein Notebook so und ich kenne auch andere, die das Notebook hinten aufbocken. Eine schräge Tastatur ist nämlich ergonomischer. Und so ein 16er wird oft genug wohl ein Desktop Replacement sein und wenn man es doch mal mobil nutzt, kann an ja das GPU-Modul rausnehmen. Dafür ist es ja ein Modul.

Allerdings der Preis... Wenn die 5070 schon so affen teuer ist, dann würd ne noch größere wohl unbezahlbar sein. AMD wäre die Alternative. Also meine OneXPlayer eGPU2 mit rx7800m/12GB hat ziemlich genau so viel gekostet wie das Nvidia-Modul, und OneXPlayer fertigt sicher kleinere Stückzahlen und musste noch das ganze Gehäuse etc. in den Kosten unterbringen. Das Design haben sie von der eGPU1 recycelt, wahrscheinlich auch das PCB. Also ich sag mal, wenn man gewollt hätte, wäre das auf jeden Fall drin gewesen und selbst bei 100 Watt performed die noch ganz gut. Und wenn das Ding dann schräg steht, kann man da auch kühltechnisch noch mehr machen und die TDP vielleicht auch erhöhen, wenn das Board das hergibt (bzw. das wäre ja dann mal was wirklich neues für die 2. Generation). Also ich denke da wäre was gegangen.

Davon mal abgesehen gibt es auch 3MBit Chips. Nvidia wird es natürlich verbieten, aber AMD mag vielleicht offen sein für ne rx9060 8GB durch 3MBit Chips auf 12GB hochgerüstet. Wenn man den Chip selektiert und das ganze komplett durchoptimiert, käme da denke ich schon so was sehr ansehliches bei raus, was auch platzmäßig in das bestehende Modul passen könnte.

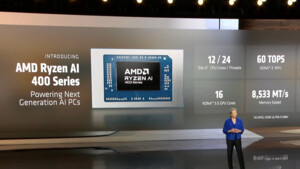

Bzgl. der CPU auch anschließend an die andere Diskussion: Die sind gut, aber das Geld sind sie nicht wert. Da muss ich leider zustimmen. Und von der Performance her kann man die auch auslassen. Die 7000er/8000er sind nach wie vor meiner Auffassung nach die besten speziell wenn man den Preis berücksichtigt. AMD hat da definitiv überzogen. Das ist einfach zu viel. Die müssten preisgleich kommen (ohne Rabatt). So ist die 1. Generation definitiv der bessere Deal mit dem kleinen Rabatt. Für den Preis des neuen mit der großen CPU, die dann auch 16 CU hat, bekommt man von der 1. Generation die kleine CPU (die große bringt nur minimale Vorteile) und fast noch die 7700S dazu und die fährt Kreise um die (sehr gute) iGPU. Da musste schon scharf auf 12 CPU Cores sein. Die kleine neue CPU ist hingegen ein Witz. Die iGPU ist ja schwächer als die alte und die CPU maximal genau so gut. Das ist kein Upgrade. Außer dieser AI-Kappes interessiert einen.

Immerhin: Das 5070 Modul passt auch ins alte. Das ist mal richtig gut. Und damit lösen sie immerhin das Versprechen ein, dass man wirklich upgraden kann, wenn auch dieses Upgrade meiner Auffassung nach sich nicht lohnt.