Jeder Hersteller wird ein Modell zum FE-UVP haben. Das war auch bei den bereits geleakten Karten von Gigabyte so und ist m.W. auch von NVidia so vorgeschrieben.Fighter1993 schrieb:Eine FE kannst du Knicken und das ist die einzigste zur UVP. Die 100 Karten für Deutschland sind schneller per Bot gekauft als du klicken kannst…

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Test Nvidia GeForce RTX 5090 im Test: DLSS 4 MFG trifft 575 Watt im 2-Slot-Format

Fighter1993

Admiral Pro

- Registriert

- Juli 2009

- Beiträge

- 8.452

Leider hat die Karte jetzt schon zu wenig VRam für 4K.GrooveXT schrieb:Wenn in 2-4 Jahren dann die 5080 zu wenig Speicher hat, einfach beides verkaufen und die 7080 ist dann quasi umsonst.

Ja, das stimmt. In einigen KI-Workloads scheint die 5090 aus dem Stand heraus (ohne zukünftige Software-Optimierungen für die 500er-Generation) wirklich deutlich performanter zu sein.nutrix schrieb:https://www.hardwareluxx.de/index.p...x-5090-founders-edition-im-test.html?start=19

Leider vollkommen unbeachtet:

FB4 ist 4x schneller als bei der 4090.Code:Flux.1 dev FP8 Flux.1 dev FP4 RTX 5090 6.42 s/ Bild 3.807 s/ Bild RTX 4090 10.812 s/ Bild 17.187 s/ Bild RTX 4080 15.459 s/ Bild 28.935 s/ Bild

Fighter1993

Admiral Pro

- Registriert

- Juli 2009

- Beiträge

- 8.452

Ah ok das wusste ich gar nicht. Das ist doch Nice.Grestorn schrieb:Jeder Hersteller wird ein Modell zum FE-UVP haben. Das war auch bei den bereits geleakten Karten von Gigabyte so und ist m.W. auch von NVidia so vorgeschrieben.

Ich habs noch mit einem Beispiel UE5 und 4k Path Tracing erweitert.moby_dick schrieb:Ja, das stimmt. In einigen KI-Workloads scheint die 5090 aus dem Stand heraus (ohne zukünftige Software-Optimierungen für die 500er-Generation) wirklich deutlich performanter zu sein.

Daher, die Pros feiern bestimmt alle diese Karte jetzt, und die werden gerne den Gamern die 5090 wegschnappen. So schlecht, wie sie jetzt alle hier hinstellen wollen, ist die GPU gar nicht.

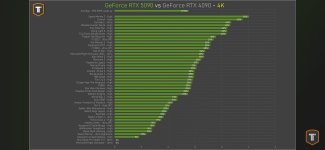

Hier in 45 games aufgerundet 30% vor der 4090 und mit mfg ist Sie nochmal doppelt so schnell.Surtia schrieb:Welch entrückte Mondnachrichten hast du konsumiert? Habe ich was verpasst - bitte kläre mich auf. Wo erhalte ich 30 bis 100 % mehr FPS mit einer 5090 gegenüber meiner 4090? Ich zocke in 4k und wenn möglich immer mit RTX, HDR sowie ohne DLSS. Abgesehen davon zweifle ich, dass ich nach dem Release noch 1500 € für die 4090 bekomme.

Wenn du dlss nicht nutzt ist dein Problem. 80% der Spieler nutzt es

Anhänge

Es wird aber vermutlich wie bei der 4090 laufen: zu Release gibt es diese Karten und danach verschwinden sie, weil "nicht lieferbar" und man bekommt nur die teurere, aber eigentlich identische, "OC" Variante.Grestorn schrieb:Jeder Hersteller wird ein Modell zum FE-UVP haben. Das war auch bei den bereits geleakten Karten von Gigabyte so und ist m.W. auch von NVidia so vorgeschrieben.

Abwarten, einige Varianzen hier je nach Game + Setting sind auffällig.Serandi schrieb:Wieso sollte die 5090 so viel besser werden,

Ich bin mir sicher, dass wir dieses Jahr 2025 zahlreiche Games sehen werden, in denen die 5090 eine 4090 um 40-50% mehr fps deklassiert und bereits in den 0.1% Percentil fps deutlich vor den avg fps for einer 4090 landet, also noch flüssiger mit mehr fps läuft und noch weichere/smoothere Frametimes abliefert.

Die 5090 wird in Zukunft bessere Skalierungseffekte zeigen als in den Day 1 Tests.

Die Ungewißheit bzw. das alleine wird vielen dennoch zu wenig Sicherheit geben für einen Umstieg, finde ich auch plausibel.

Zudem bleibt die 4090 ein Monster.

Die 5080 Tests werden die 4090 voraussichtlich in ihrer Position als zweitschnellste GPU auch die nächsten 2 Jahre manifestieren.

Btw interessieren mich nur für das Isolieren des CPU Limits mal 8K Tests der 4090 vs 5090.

Cohen

Commodore

- Registriert

- Aug. 2010

- Beiträge

- 4.896

Du gehst also davon aus, dass sich die nächste Xbox und/oder die PS6 deutlich von der 4090 absetzen können? Erstmal abwarten, auch im Konsolenbereich geht die Hardwareentwicklung immer langsamer voran.MeisterOek schrieb:Oh wow, also ich glaube die 4090 wird tatsächlich die letzte Grafikkarte in meinem Besitz sein, denn ich schwenke dann wohl komplett auf Konsole um, wenn die 4090 in "vielen" Jahren die aktuellen Games nicht mehr stemmen kann.

- Registriert

- Jan. 2007

- Beiträge

- 2.676

Ok, in welchen Reallife Szenarien ist das so?Fighter1993 schrieb:Leider hat die Karte jetzt schon zu wenig VRam für 4K.

Welche Artefakte hat man denn bei dem Spiel? Moiré? Smearing? Ghosting?Capthowdy schrieb:Doch, geht es indirekt schon. Wenn das Ausgangsmaterial von besserer Qualität ist, kommt auch bessere Qualität mit weniger Artefakten raus.

Reicht mir ja, ich bestelle gleich bei Release zum UVP.Capthowdy schrieb:Es wird aber vermutlich wie bei der 4090 laufen: zu Release gibt es diese Karten und danach verschwinden sie, weil "nicht lieferbar" und man bekommt nur die teurere, aber eigentlich identische, "OC" Variante.

Ergänzung ()

Quatsch.Fighter1993 schrieb:Leider hat die Karte jetzt schon zu wenig VRam für 4K.

Der 9800x3D wird hier bereits zu langsam sein, um die 5090 zu fluten, und wer das lustig findet, darf gerne bei den 10800x3D Tests meinen Beitrag hier zitieren, wenn sich alle wundern, warum der Vorsprung der 5090 zur 4090 bei den gleichen RT Szenarien mit derselben CPU doch "unerwartet" größer wird, vor allem deutlich im min-fps Korridor.F4711 schrieb:Mich erstaunt der relativ niedrige Zuwachs bei RT.

Ich könnte mir Vorstellen, dass gerade auch bei RT ein Auslastungsproblem zum Tragen kommt. Nicht nur bei der GPU sondern auch durch ein CPU-Limit.F4711 schrieb:Mich erstaunt der relativ niedrige Zuwachs bei RT. Sind die fetten Performance Sprünge bei nativer Auflösung und Raytracing bereits vorbei? Soll jetzt alles über upsamling und FG laufen? Dachte wir würden nochmal echte Sprünge bei RT stehen..

Mal sehen, was die Zukunft bringt, speziell wenn man die Engines noch besser auf Blackwell optimiert.

- Registriert

- Juli 2021

- Beiträge

- 1.355

@Laphonso

Sicherlich werden Firmware und Treiberupdates noch einiges rausholen können aber bezweifle es doch sehr, dass da noch so viel geht und wenn, dann wird es auch auf den 40ern gehen oder Nvidia lässt die genau deshalb extra ablaufen um die 40er künstlich zu kastrieren und die 50er besser dastehen zu lassen, da haben sie ja auch das Szepter in der Hand, wenns um die Konkurrenz der eigenen Karten geht.

Aber völlig klar, mehr Leistung durch kommende Treiberupdates usw erwarte ich ebenso.

Solche 8k Tests kommen schon sehr bald in Hülle und Fülle.

Sicherlich werden Firmware und Treiberupdates noch einiges rausholen können aber bezweifle es doch sehr, dass da noch so viel geht und wenn, dann wird es auch auf den 40ern gehen oder Nvidia lässt die genau deshalb extra ablaufen um die 40er künstlich zu kastrieren und die 50er besser dastehen zu lassen, da haben sie ja auch das Szepter in der Hand, wenns um die Konkurrenz der eigenen Karten geht.

Aber völlig klar, mehr Leistung durch kommende Treiberupdates usw erwarte ich ebenso.

Solche 8k Tests kommen schon sehr bald in Hülle und Fülle.

Fighter1993

Admiral Pro

- Registriert

- Juli 2009

- Beiträge

- 8.452

Ich meinte das ehr so das ich jetzt nicht nochmal 1300€ ausgebe für 16GB und die Spiele in Zukunft werden mehr VRAM verbrauchen. Einfach weil die 4090 und 5090 dieses liefern.GrooveXT schrieb:Ok, in welchen Reallife Szenarien ist das so?

Ergänzung ()

Ihr wisst das ich von der 5080 spreche richtig?Grestorn schrieb:Quatsch

Danke, ich stand wohl echt auf dem Schlauch. Manchmal bringe ich die Begriffe ein wenig durcheinander. Ich meinte nicht SuperSampling im Allgemeinen sondern Oversampling aka OGSSAA im Speziellen.Grestorn schrieb:Man kann bei Supersampling auch so vorgehen, dass nicht die Auflösung erhöht wird, sondern das gesamte Bild mehrfach gerendert wird, jeweils um einen minimalen Betrag (kleiner als ein Pixel) versetzt (jittered).

bei dem einfachen SuperSampling mag das stimmen, aber gemäß Nyquist-Shannon-Abtasttheorem reicht die doppelte Frequenz (hier Pixel je Richtung) aus um ein Signal exakt zu rekonstruieren (genau genommen nicht =2 sondern >2). Es kann also gar nicht besser werden als 2xOGSSAA.Grestorn schrieb:D.h. Du hast mit DLAA von der Menge an Informationen, deutlich mehr als bei klassischem SuperSampling.

Das stimmt so nicht und das kann man auch ganz leicht beweisen. Zuerst erstellst du ein Bild mit 2xOGSSAA. Das nimmst du als Referenz. Dann nimmst du eins mit DLAA. Jetzt vergleichst du die Werte von 2xOGSSAA und DLAA mit der Referenz. Jedes Pixel, das nicht exakt übereinstimmt ist ein Fehler. Da du 2xOGSSAA als Referenz hast ist jedes Pixel von 2xOGSSAA exakt gleich der Referenz (ist logisch, da es ja ein und dasselbe Bild ist). DLAA wird wahrscheinlich viele Abweichungen haben, also Fehler. Somit kann DLAA nicht besser sein als 2xOGSSAA.Grestorn schrieb:Bei einem Standbild wird DLAA aber immer massiv jedem SS überlegen sein.

Und mal ehrlich: Wer vergleicht schon Standbilder? Wer das tut, hat absolut nichts verstanden. Das ergibt einfach keinen Sinn.

Ja. 16GB sind auf die nächsten Jahre genug. Auch wenn es mal ein Spiel gibt, dessen Texturcache so hoch einstellbar ist, dass man die 16GB knacken kann.Fighter1993 schrieb:Ihr wisst das ich von der 5080 spreche richtig?

Ich kann immer eine solche Konfig machen, die den Speicher knackt. Einfach mal 20GB Texture-Cache... rums.

Ob der dann optisch irgendeinen Unterschied macht, steht auf einem ganz anderen Blatt.

Genau die Diskussion hatten wir bei Doom:Eternal, das die selbe unsinnige Einstellungsmöglichkeit hat.

Zuletzt bearbeitet:

Die VRAM Hysterie finde ich auch absurd, hier ist es vor allem ein Marketing Problem, dass eine 2000 Euro Custom 5080 (da werden einige landen!) nur 16 GB VRAM wie die 4080er hat und weniger als die 3090er aus 2020 Vor-Vorgeneration.Grestorn schrieb:Quatsch.

Wir wissen nicht, inwieweit 4 K Games die 16 GB VRAM penetrieren werden, weil AMD dieses "Nvidia geizt beim VRAM" Defizit ausnutzen MUSS und wird.

Wir werden UHD RT/PT Szenarien haben, bei denen nicht nur die Allokation das Thema wird (ich habe schon in uwqhd bereits 21 GB "Belegung" gesehen bei der 4090..war aber nie usage) , sondern akute usage, und wenn die 16 GB VRAM nahezu ausgefüllt sind, müssen wir erstmal sehen, ob und wie die GDDR7 VRAM Architektur hier kompensieren kann oder nicht.

Pauschal ist die Aussage 16 GB VRAM für 4K seien zu wenig sicher Quatsch.

Aber das ist schon eine Wette, dass es nicht ggf. genau 1 oder 2 Games weitere gibt dieses Jahr, bei denen ultramaxed 4K Settings wieder dann 17-20 GB VRAM "fordern".

AMD sponsored Games würde ich da vermuten, und ich würde es nicht ausschließen ;-)

Nvidia hat ja auch den Cyberpunk Showcase, und da wird die 5080 ein visuelles porn Feuerwerk abschießen, ohne Probleme mit 16 GB VRAM.

Einige hier werden Sorgen haben, 1500-2000 Euro auf diese 16 GB VRAM Wette abzuschließen, darum gehts.

Und manche werden sich der Möglichkeit verweigern, ein Setting dann 1 Stufe zu reduzieren (so dass die 16 GB dann wieder easy ausreichen). Aus Prinzip, damit das Narrativ stimmt

Leider differenzieren wir alle hier zu selten...

Zuletzt bearbeitet:

Ähnliche Themen

- Antworten

- 959

- Aufrufe

- 96.371

- Antworten

- 652

- Aufrufe

- 75.846

- Antworten

- 532

- Aufrufe

- 44.603

- Antworten

- 115

- Aufrufe

- 9.934

- Antworten

- 441

- Aufrufe

- 46.448