ReactivateMe347 schrieb:

Naja, das OS liest Daten, Controller meldet (unkorrigierbarer) Lesefehler. Damit kann das DAteisystem bzw das OS dann entsprechend umgehen.

Ja, im besten Fall handelt es sich um eine reine Datenplatte und es sind nur einzelne Dateien betroffen. Es kann aber auch schlimmer werden, falls es sich um Metadaten des Dateisystems handelt, eine SSD mit Betriebssystem, usw.

Ich war in meinem ersten Beitrag mit Absicht gar nicht auf sowas wie Read-only Modi eingegangen. Mir ging es primär um die Einschätzung, dass eine SSD nicht einfach schrumpft und sich ohne Spare Blocks das Lebensende nähern wird.

Eine gute Firmware sollte natürlich eine Datenrettung ermöglichen. Und sollte so eine Funktion vorhanden sein, wird es auf den implementierten Schwellwert ankommen.

ReactivateMe347 schrieb:

Ohne Schreibvorgänge? Wie kommst du darauf? Wieso sollte der Controller "zum Spaß" Daten verschieben?

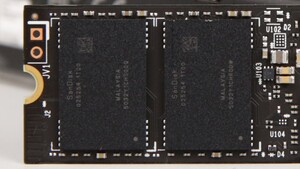

Das zweite Stichwort, welches ich genannt hatte, war Cell Refresh. Das hat mit der Art und Weise zu tun, wie Daten in den NAND Zellen gespeichert werden. Dort liegt eine

Spannung Ladung an, welche den Inhalt repräsentiert. Beim Auslesen des NAND wird vom Controller eine Referenzspannung angelegt und die verschiedenen Zustände der Zellen können ausgelesen werden, solange die Spannung stabil ist (Threshold Voltage). Bauartbedingt kann die

Spannung Ladung in den Zellen aber nicht dauerhaft gehalten werden (Charge Leakage).

Eine der größten Herausforderungen bei der Entwicklung der neuen NAND Technologien mit mehr Bits pro Zelle ist die Gewährleistung der Datenintigrität. Bei QLC muss eine Zelle beispielsweise schon 16 Spannungszustände abbilden können, was die Toleranzen immer weiter einschränkt.

Die Hersteller der Controller kombinieren oft eine Vielzahl von Techniken um das zu realisieren. ECC Algorithmen, Read-Retry mit anderen Referenzspannungen, verschiedene Patrol Reads. Und eine Basistechnik ist dabei der Cell Refresh. Ist bei einer Zelle der Inhalt nicht mehr sauber erkennbar, werden die Daten rechtzeitig (bedeutet: kann noch rekonstruiert werden) neu geschrieben (was durch Wear Leveling dann wahrscheinlich woanders passiert).

Hier ist ein interessanter Beitrag von Phison, wie die das machen:

https://phisonblog.com/phisons-smartrefresh-2/

Die Folge ist dann, dass eine SSD ohne Spare Blocks irgendwann sicher tot ist. Was die einzelnen SSD Hersteller und/oder Controller Hersteller da noch an Read-only Periode ermöglichen, kann ich nicht sagen. Soweit ich das weiß, wird das in der Regel auch nicht angegeben.

Die Samsung 980 Pro hatte mal einen Bug, welche zu "sehr starker Abnutzung" geführt hatte. Im schlimmsten Fall waren die unwiderruflich in einem Read-only Zustand.

https://www.computerbase.de/news/st...sd-firmware-update-gegen-read-only-bug.83246/

Vielleicht hast du schon mal gehört, dass man SSDs nicht dauerhaft ohne Strom "im Schrank" lagern soll. Im Grunde steckt da die gleiche Problematik hinter. Auch wenn es da Modelle geben soll, die das besser vertragen sollen als andere.

Edit: Verwendung von Spannung/Ladung etwas überarbeitet. Hoffentlich passt das so ;-)