Chinas neuer AI-Chip: Huawei Ascend 910C ist leistungsstärker, aber ineffizient

Der neue Huawei Ascend 910C ist in Serienproduktion und soll ab Mai ausgeliefert werden. Er ist leistungsstark, aber wenig effizient, vor allem im Vergleich zu Nvidias Chips. Hier zeigt sich die rückständigere Fertigung, auf der der Chip basiert, obwohl er noch immer zu großen Teilen von TSMC stammt und Samsung-HBM nutzt.

Schon seit Monaten ist der 910C als die nächste Auskopplung des 910B bekannt – ein 910C sind letztlich einfach zwei 910B-Chips in einem Package. Auch der Fahrplan war lange entsprechend ausgelegt, denn schon seit dem letzten Jahr wurden die Chips dafür gehortet. Nun wird mit mehr aber weiterhin nicht offiziellen Details jedoch die Auslieferung gestartet.

Made in Taiwan mit Speicher von Samsung

Die interessantesten Details dafür lieferte ein Bericht von Semianalysis bereits in der letzten Woche, Reuters sprang am Wochenende nur auf den Zug auf und erklärte, das die Chips im Mai kommen werden. Wie Semianalysis erläuterte, stammen je nach Charge nahezu alle Teile beim Ascend 910B und auch Ascend 910C von TSMC – durch den Mittelsmann Sophgo.

In fact, the US Government, TechInsights, and others have acquired Ascend 910B and 910C and every single one used TSMC dies. Huawei was able to circumvent the sanctions on them against TSMC by purchasing ~$500 million of 7nm wafers through another company, Sophgo.

Semianalysis

Huawei soll für rund 500 Millionen US-Dollar Wafer mit 7-nm-Chips von TSMC bezogen haben – TSMC wurde dafür bekanntlich vor einigen Wochen bestraft – rund eine Milliarde US-Dollar könnte TSMC dies kosten. Ob es das Ende ist, bleibt unbekannt. Gerüchte munkeln, dass anstelle von Sophgo nun ein anderes Unternehmen für Huawei die Chips von TSMC kauft. Huawei verneint bis heute, dass es für die Art Chips TSMC nutzt.

Ohne TSMC wäre Chinas AI-Chip noch lange nicht da, wo er jetzt steht. Als weitere wichtige Komponente kommt HBM hinzu. Auch hier kann China noch nichts vorweisen, Huawei und Partner sollen stattdessen Millionen Stück von Samsung gehortet haben. Dabei könnte es um eine Größenordnung von bis zu 13 Millionen Einheiten HBM2e gehen, die für 1,6 Millionen Ascend 910C reichen würden.

Eine Nvidia-Blaupause für das Rack-Design

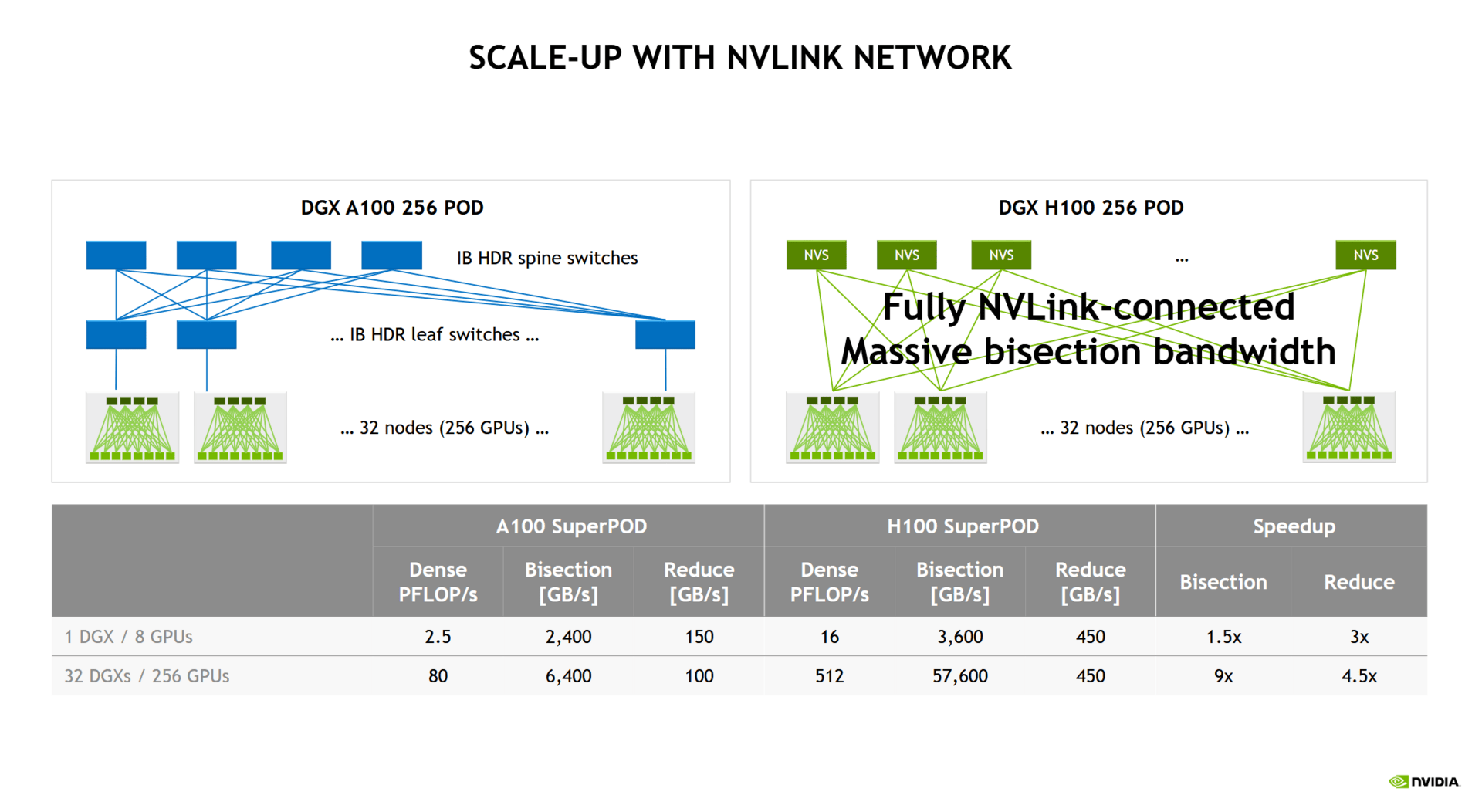

Viel gelernt hat Huawei von Nvidia, wie Racks und Cluster auszusehen haben, um im AI-Zeitalter mitzuspielen. Nvidia hat derartige Konstruktionen aber zurückgestellt, da einige benötigte Teile wie unzählige optische Verbindungen für den Datentransfer sehr viel kosten als auch den Stromverbrauch in die Höhe treiben würden. Der DGX H100 NVL256 Superpod kam so letztlich nicht, auch die Nachfolgedesigns sind eher im Bereich NVL72 oder NVL36 präsent.

Doch Huawei setzt genau dort an. In der Cloudmatrix 384 sind 16 Racks verbaut, 12 Compute-Racks setzen auf jeweils 32 GPUs, vier Racks sind für die Netzwerktechnik vorgesehen. 384 Ascend 910C arbeiten letztlich über tausende LPO-Transceiver (Linear Pluggable Optics) zusammen und sollen so über die Masse das ausgleichen, was an Rohleistung eines einzelnen Chips fehlt.

Und das klappt. Gegenüber einem Nvidia GB200 NVL72, der auf 72 Blackwell-Chips setzt, bietet das System mit fünf Mal so vielen Chips mitunter nun auch mehr Leistung. Durch die Masse der Chips wird jedoch viel mehr Speicher und eine höhere Speicherbandbreite zur Verfügung gestellt.

Das Huawei-System verbraucht am Ende vier Mal mehr Strom als das von Nvidia, ist also deutlich ineffizienter. Doch in China ist dies wohl das geringste Übel, denn an Strom zu kommen ist viel einfacher, als an Silizium.