Bei CPUs greife ich meistens immer im 500€ Bereich zu, lieber etwas weniger. Habe zwar auch schon wesentlich mehr ausgegeben, aber ungern. Das lohnt sich für einen Otto-Normal-Verbraucher meistens nicht. Knechten muss der Prozessor aber oft bei mir, Video Encoding und Verpacken sehr großer Dateien ist dieser Umstand geschuldet. Bei mir sind im Extremfall auch bei 250W CPU Verbrauch aus dem Verstand heraus Schluss, denn irgendwann kann man den PC nicht mehr vernünftig und leise mit Luft kühlen.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

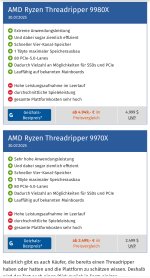

Test AMD Ryzen Threadripper 9000 im Test: HEDT-CPUs mit 32 & 64 Kernen gegen Ryzen, Core und 5 Jahre alten 64-Kerner

Erscheint sehr sinnvoll für KI-Anwendungen.

Gerade beim Training großer Bild- oder Sprach-KI-Modelle werden bei großen Batch-Sizes (Anzahl an Trainingsbeispiele die das zu trainierende Modell gleichzeitig sieht) viele Transformationen der Daten auf der CPU durchgeführt, bevor diese Daten auf der GPU verarbeitet werden. Bei Multi-GPU-Training kommt eine CPU mit zb. 16 Kernen deutlich schneller ans Limit und wirkt als Bottleneck im Training ggü. 32 oder mehr CPU-Kernen.

Sehr große Batch-Sizes sind sehr wichtig für den Bereich selbst-überwachten Lernens (self-supervised learning). Hier wird mit Batch-Sizes von 8000+ Beispielen, die das KI-Modell gleichzeitig sieht, trainiert und diese besonders hohen Batch-Sizes werden durch ein Multi-GPU-Setup erst ermöglicht.

Gerade beim Training großer Bild- oder Sprach-KI-Modelle werden bei großen Batch-Sizes (Anzahl an Trainingsbeispiele die das zu trainierende Modell gleichzeitig sieht) viele Transformationen der Daten auf der CPU durchgeführt, bevor diese Daten auf der GPU verarbeitet werden. Bei Multi-GPU-Training kommt eine CPU mit zb. 16 Kernen deutlich schneller ans Limit und wirkt als Bottleneck im Training ggü. 32 oder mehr CPU-Kernen.

Sehr große Batch-Sizes sind sehr wichtig für den Bereich selbst-überwachten Lernens (self-supervised learning). Hier wird mit Batch-Sizes von 8000+ Beispielen, die das KI-Modell gleichzeitig sieht, trainiert und diese besonders hohen Batch-Sizes werden durch ein Multi-GPU-Setup erst ermöglicht.

Zuletzt bearbeitet:

Gullveig

Lieutenant

- Registriert

- Feb. 2024

- Beiträge

- 954

Ich hab mir extra nochmal die zwei Gamingbenches angeschaut. Anno hat wohl irgendein Problem weil die Werte zueinander unplausibel wirken, und das andere Spiel hat 20%, bei einer nicht genannten Auflösung - ich vermute mal es sind die berüchtigten 720p.silentdragon95 schrieb:Sehe ich anders. Ich war überzeugter HEDT-Kunde zu Zeiten von X79, X99 und X299 und wäre das auch heute noch, wenn es eben noch die Eierlegende Wollmilchsau von damals wäre.

Ich behaupte es ist immer noch die eierlegende Wollmilchsau, und zwar mehr als je zuvor.

Ich verstehe auch nicht, warum es hier keinen CB Award gibt. Hat die GTX5090 ja auch bekommen.

Welche Karte soll das sein?Gullveig schrieb:Hat die GTX5090 ja auch bekommen.

Eine kastrierte RTX5090 mit ohne Raytracing?

Gaming-Opa

Ensign

- Registriert

- Dez. 2023

- Beiträge

- 162

Echt jetzt? Du kannst Dir ein Szenario vorstellen, bei dem jemand ca. 6500€ für CPU/MB/RAM ausgibt, dann noch ca. 2500€ für eine 5090 (je andere GPU würde in diesem Zusammenhang keinen Sinn ergeben) und dann irgend etwas in 720p zockt? Die einzige Frage die sich doch in der echten, realen Welt, in der ich zumindest lebe, ist ob 4K oder 8k. Und die ist auch sehr einfach zu beantworten: 8K! Denn wenn ich genug Geld habe um 10.000€ in einen PC zu stecken, ohne zu verarmen, sollte ich mir doch auch ein passendes visuelles Medium zulegen, oder etwa nicht?fanaticmd schrieb:Alles andere macht auch keinen Sinn...

Wenn interessiert denn wie CPUs/Kerne skalieren/sich bei Spielen unterscheiden? Die Wahl der richtigen SSD ist z.B. für das reale Gaming-Erlebnis wesentlich bedeutender als mit welcher CPU man zockt. Oder die Menge an verbautem RAM (wobei hier alle Benchmark-Fetisten auch der Meinung sind 32GB wären völlig ausreichend). Ja es gibt vielleicht eine Handvoll Games, die tatsächlich spürbar mit der CPU skalieren, aber die hat man in 3 Monaten durchgezockt und dann?

Es gibt SP6 zwischen AM5 und SP5. Und es soll SP7 und SP8 geben.Der_Unbekannte schrieb:Und das letzte Mal, als ich in dieser sagenumwobenen „Realität“ nachgesehen habe, gibt es keinen „mittleren“ Sockel, und es gibt noch nicht einmal Gerüchte, das ein solcher geplant ist.

fanaticmd

Commander

- Registriert

- März 2019

- Beiträge

- 2.668

@Gaming-Opa

Hast du alles gelesen und verstanden?

Oder nach deinem Zitat aufgehört zu lesen?

Ich habe explizit deine Erwähnung der Gaming Test auf 720p zitiert und darauf geantwortet und auch gleich erklärt.

Von „auf 720p zocken“ kein Wort zu finden.

Wenn die CPU in 720p 200 FPS schafft dann schafft die CPU es auch in 4K/8K/nK!!!

In 4K zu testen wäre ein GPU oder System Test und nichts anderes, hier geht es aber um die CPU!

Falls es jetzt noch nicht durchdringt dann empfehle ich dir mal die Hilfethreads von HisN zu lesen der erklärt das dort sehr ausführlich

Hast du alles gelesen und verstanden?

Oder nach deinem Zitat aufgehört zu lesen?

Ich habe explizit deine Erwähnung der Gaming Test auf 720p zitiert und darauf geantwortet und auch gleich erklärt.

Von „auf 720p zocken“ kein Wort zu finden.

Wenn die CPU in 720p 200 FPS schafft dann schafft die CPU es auch in 4K/8K/nK!!!

In 4K zu testen wäre ein GPU oder System Test und nichts anderes, hier geht es aber um die CPU!

Falls es jetzt noch nicht durchdringt dann empfehle ich dir mal die Hilfethreads von HisN zu lesen der erklärt das dort sehr ausführlich

Zuletzt bearbeitet:

magiceye04

Ensign

- Registriert

- Feb. 2010

- Beiträge

- 139

Es geht letztendlich alles schneller bzw. in Echtzeit.raychan schrieb:Ich frag mich welche Anwendung benötigen diese CPU? Also früher vor 10-20jahren kann ich das verstehen, aber heute braucht man selbst im Foto und Videobereich nicht Mal diese CPUs. 🤔

Ergänzung ()

Auf einem Notebook brauch ich gar keine große Rechenleistung. Wenn dort die CPUs so sparsam wären, dass sie keinen Lüfter mehr brauchen, wäre ich wunschlos glücklich. Außer Apple gibts da meines Wissens immer noch nix.SavageSkull schrieb:Noch schlimmer sind diese super dünnen Notebooks, die teilweise immer noch mit 2/4er Krücken unterwegs sind.

Gaming-Opa

Ensign

- Registriert

- Dez. 2023

- Beiträge

- 162

Klar wenn jemand eine andere Sicht auf die Dinge hat, hat er deine nur nicht richtig verstanden.fanaticmd schrieb:Hast du alles gelesen und verstanden?

fanaticmd schrieb:Wenn die CPU in 720p 200 FPS schafft dann schafft die CPU es auch in 4K/8K/nK!!!

Das stimmt natürlich, hat aber trotzdem genau 0,0 Bedeutung/Relevanz. Denn der Umkehrschluß ist einzig und allein von Bedeutung, und läßt sich aber durch diese Aussage/Feststellung nicht treffen. Soll heißen, daß wenn die CPU es eben nicht schafft in 720p X FPS zu bringen, sie auch schlechter in 4K/8K wäre. Dem ist eben nicht so.

Oder anders gesagt: Eine 200€ CPU performt bei 98% aller Gaming-Fälle in 4K genausogut wie eine 700€ CPU oder gar wie im vorliegendem Fall eine 5000€ CPU. Da die aktuellen TR mehr als gut genug fürs Gaming sind ist eigentlich selbstredend und muß nicht bewiesen werden. 8+ Kerne, >5GHz ist mehr als genug fürs "normale" 4K Gaming. Das muß nicht extra getestet werden.

Oder noch schlichter: Die CPU - egal welche - egal von wem - spielt fast KEINE Rolle im realen Gaming Alltag. Doch solche FPS-Tests wollen mit Gewalt weiß machen, daß da ein Unterschied wäre wo keiner ist.

Das führt letztendlich daß Leute, die zu wenig darüber wissen/nachdenken (zuviel) Geld in die falsche Komponenten stecken (CPU, RAM) anstatt in die richtigen (1. Bildschirm, 2. GPU, 3. SSD). Letztendlich ist es primitive Marketingmanipulation. In jedem Mann steckt ein Junge und der will immer den größten haben. Lies Dir mal die Antworten durch. Da gibt es welche denen ist der letzte TR, den sie schon besitzen, schon zu viel, trotzdem überkommt sie der Haben-will-Effekt!

iron_monkey schrieb:Kannst mir mal die Spiele nennen, ich musste jetzt seit Release des 7959x3d kein einziges mal auch nur einen Kern im UEFI abschalten für irgendein Spiel.

Nein tut mir leid. Mein letztes AMD System war ein Athlon XP, daher hab ich zugegeben keine eigene Erfahrungen. Trotzdem hört/liest man so einiges, behält es im Hinterkopf, usw. Hab z.B. von so manchem AMD X900/X950 User gelesen, daß er sein 2. Chiplet im BIOS deaktiviert hat um keine Probleme zu haben.

Ich möchte nicht in Abrede stellen, daß es vielleicht Wege gibt/gäbe dies besser zu handhaben, aber letztendlich bleibt der unstrittige Fakt, daß nicht jeder dies kann, bzw über genug Wissen verfügt, um dies richtig zu händeln.

Ist doch völlig egal wie oder mit was ich ein Problem umgehe/löse. Was bleibt ist, daß es problematisch ist. Daß man ein Problem lösen kann, ist doch keine Daseinsberechtigung für eben jenes.iron_monkey schrieb:Nein, wenn du mit dem ProcessLasso ...

iron_monkey schrieb:Die besten 9800x3d sitzen auf den 16 Kernern, AMD zwingt dich aber einen normalen 8 Kerner" mitzukaufen"...

Absolut richtig. Und genau das ist auch das Problem unserer Tage. Heutzutage wird den Leuten Schrott, pardon Ausschuß verkauft und redet das schön als Bining. Das ist einerseits das Resultat von immer feineren Strukturen, wo bald die einzelnen Atomen zwischen den Transistoren zählen kann, andererseits daß schon der Grundtakt auch ohne OC absurd zu hoch über den Leistung-pro-Watt-Sweetpoint gelegt wird.

Zuletzt bearbeitet:

iron_monkey

Vice Admiral

- Registriert

- Juli 2005

- Beiträge

- 6.462

fanaticmd schrieb:Hast du alles gelesen und verstanden?

Oder nach deinem Zitat aufgehört zu lesen?

Ich lasse sie mittlerweile in ihrer Blase, alles andere ist nur Energieverschwendung, denn auch unsere Rechenleistung kostet Energie. Ich rette die Umwelt damit ein bisschen, sozusagen :-D

@iron_monkey der eine Frame mehr auf ein 9950x3d im Vergleich zum 9800x3d war mir die 200€ Aufpreis jetzt nicht wert

So bekloppt bin ich denn doch nicht, für das bisschen mein Geld zum Fenster rauszublasen

Da ist es mir dann egal, ob d der schlechtere ccd auf meiner CPU sitzt, Hauptsache er erfüllt seine angegebene specs….

So bekloppt bin ich denn doch nicht, für das bisschen mein Geld zum Fenster rauszublasen

Da ist es mir dann egal, ob d der schlechtere ccd auf meiner CPU sitzt, Hauptsache er erfüllt seine angegebene specs….

gigabyte²

Lieutenant

- Registriert

- März 2009

- Beiträge

- 674

wern001 schrieb:Hab ich das über sehen oder steht es gar nicht drin in welcher Auflösung?

Anhänge

wern001

Admiral

- Registriert

- Mai 2017

- Beiträge

- 8.924

@gigabyte² was willst Du mit dem nichtssagenden Post der screenshots andeuten?

ob ein Spielebenchmark in 720p oder uhd gemacht wird ist ein deutlicher unterschied! Ich glaub jetzt mal nicht das irgend ein Threadripper Besitzer in 720p zockt.

Ich gehöre zur Fraktion UHD und Grafikdeteils auf max mit Framelimit @60 FPS @ 120 Hz

ob ein Spielebenchmark in 720p oder uhd gemacht wird ist ein deutlicher unterschied! Ich glaub jetzt mal nicht das irgend ein Threadripper Besitzer in 720p zockt.

Ich gehöre zur Fraktion UHD und Grafikdeteils auf max mit Framelimit @60 FPS @ 120 Hz

Topflappen

Lt. Commander Pro

- Registriert

- März 2011

- Beiträge

- 1.887

Es gibt Dinge im Leben, die ab Tag 1 quasi irrelevant aussehen. Eine so dermaßen teure Anschaffung für 99,9% aller User durchaus.

Mag sich für AMD trotzdem lohnen, dann machen die sehr selbstbewussten Preise durchaus Sinn.

Mag sich für AMD trotzdem lohnen, dann machen die sehr selbstbewussten Preise durchaus Sinn.

gigabyte²

Lieutenant

- Registriert

- März 2009

- Beiträge

- 674

@wern001 Dass die Gaming-Leistung nicht mit einem 9800X3D mithalten kann, ist völlig logisch, aber eben auch vollkommen irrelevant. Wer sich einen Threadripper kauft, tut das wegen Workstation-Performance, nicht wegen Gaming. Das Ding ist für Multithreading-Last, I/O, Speicherbandbreite und professionelle Anwendungen gebaut – nicht für maximale FPS. Gaming-Benchmarks bei so einer CPU überhaupt als Bewertungsmaßstab heranzuziehen, ist ein Kategorienfehler. Genauso gut könnte man bemängeln, dass ein Serverrack kein RGB hat. Wer in UHD spielt, ist sowieso im GPU-Limit und wird bei keinem aktuellen High-End-Prozessor ernsthaft durch die CPU limitiert.

Die Gaming-Leistung bei einem Threadripper als Nachteil aufzulisten ergibt nur dann Sinn, wenn man vorher den Einsatzzweck komplett ignoriert hat. Das ist, als würde man einem LKW vorwerfen, dass er keine Bestzeit auf der Nordschleife fährt. Völlig am Einsatzzweck vorbei.

Die Gaming-Leistung bei einem Threadripper als Nachteil aufzulisten ergibt nur dann Sinn, wenn man vorher den Einsatzzweck komplett ignoriert hat. Das ist, als würde man einem LKW vorwerfen, dass er keine Bestzeit auf der Nordschleife fährt. Völlig am Einsatzzweck vorbei.

wern001

Admiral

- Registriert

- Mai 2017

- Beiträge

- 8.924

Mein TR 9970 ist eingetroffen.

Hab unter Neuer Benchmark: Die Community testet CPUs und GPUs in Cinebench 2024 die zwei Benchmarks gepostet. 1x BIOS defaults und 1x PBO + 200 MHz

Im Cinebench mit +200 MHz und einem durst von ca 500 Watt wird das Ding nicht mal 80°C (bei ca 22-23 °C Raumtemp) warm.

Ist ein wildlive Windows wo noch einiges im Hintergrund läuft. Ich schätze mit einem frisch installiertem Win11 werden es noch ein paar Punkte mehr.

Hab unter Neuer Benchmark: Die Community testet CPUs und GPUs in Cinebench 2024 die zwei Benchmarks gepostet. 1x BIOS defaults und 1x PBO + 200 MHz

Im Cinebench mit +200 MHz und einem durst von ca 500 Watt wird das Ding nicht mal 80°C (bei ca 22-23 °C Raumtemp) warm.

Ist ein wildlive Windows wo noch einiges im Hintergrund läuft. Ich schätze mit einem frisch installiertem Win11 werden es noch ein paar Punkte mehr.

Zuletzt bearbeitet:

wern001

Admiral

- Registriert

- Mai 2017

- Beiträge

- 8.924

Interessant ist das der 9970 im allcore Takte um einiges höher geht.

der 7970 machte mit PBO +200 und curve -20 bei 4900 MHz dicht.

der 9970 taktet mit PBO +200 und curve -20 auf ca 5200-5250 MHz

ist echt cremig wenn man einen 400er pack 50 MP Bilder von der 300 MB/sek SD-Karte in Lightroom importiert

der 7970 machte mit PBO +200 und curve -20 bei 4900 MHz dicht.

der 9970 taktet mit PBO +200 und curve -20 auf ca 5200-5250 MHz

ist echt cremig wenn man einen 400er pack 50 MP Bilder von der 300 MB/sek SD-Karte in Lightroom importiert

Zuletzt bearbeitet:

wern001

Admiral

- Registriert

- Mai 2017

- Beiträge

- 8.924

ein i9-10980XE hat ungefähr halb so viel Rechenleistung wie ein Threadripper 3960x.

Ein Threadripper 9970x ist ungefähr doppel so schnell wie ein 3960x

Einfach Cinebench 24 laufen lassen und vergleichen.

laut pcgh i9-10980XE ca 7870 Chinebench 20 Punkte

Threadripper 9970 mit +200 MHz PBO ca. 32500 Cinebench 20 Punkte

Ein Threadripper 9970x ist ungefähr doppel so schnell wie ein 3960x

Einfach Cinebench 24 laufen lassen und vergleichen.

laut pcgh i9-10980XE ca 7870 Chinebench 20 Punkte

Threadripper 9970 mit +200 MHz PBO ca. 32500 Cinebench 20 Punkte

Zuletzt bearbeitet:

Ähnliche Themen

- Antworten

- 180

- Aufrufe

- 20.951

- Antworten

- 231

- Aufrufe

- 35.602

- Antworten

- 65

- Aufrufe

- 12.081

- Antworten

- 116

- Aufrufe

- 24.402

- Antworten

- 448

- Aufrufe

- 137.310