-

Mitspieler gesucht? Du willst dich locker mit der Community austauschen? Schau gerne auf unserem ComputerBase Discord vorbei!

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Test Doom: The Dark Ages im Test: Benchmarks mit 25 Grafikkarten und zwei Überraschungen

ElliotAlderson

Commander

- Registriert

- Juni 2024

- Beiträge

- 2.228

Laut CB Test setzte es trotz er RT noch auf SSR.Czk666 schrieb:Ok, ist mir nicht aufgefallen. Z.b. sind mir keine Reflektionen aufgefallen welche aus dem Bild verschwinden.

Absurd ist deine Rechnung. Fertigungskosten sind nur ein Teil, neben vielen weiteren Kosten.ThirdLife schrieb:Selbst mit teurem Kühlsystem ist VRAM drecksbillig. Die Karte wird total keine 800$ in der Fertigung kosten und wurde hier für 2200€+ in den Markt gedrückt. Das ist absurd.

SweetOhm

Commander

- Registriert

- Juli 2023

- Beiträge

- 2.583

Ist sie doch ! Ansonsten würde doch nie und nimmer eine 9070XT vor der RTX 5080 landenElliotAlderson schrieb:Dabei wurde die id Tech Engine immer so gelobt, weil sie so optimiert und performant ist

Anhänge

Oder man kritisiert die Poster hier im Forum, die scheinbar überhaupt keine Ahnung von dem haben, wovon sie da eigentlich philosophieren...HerrRossi schrieb:Oder man kritisiert die Spielehersteller einfach mal, dass sie total unoptimierten Scheiß auf den Markt bringen und sich auf immer mehr Rechenleistung der Grafikkarten und immer mehr "AI"-Tricksereien verlassen.

ThirdLife

Captain

- Registriert

- Aug. 2019

- Beiträge

- 3.916

Mach ne bessere auf. "Mimimi, das ist doof" ist eher wenig Gehaltvoll.Loopman schrieb:Absurd ist deine Rechnung. Fertigungskosten sind nur ein Teil, neben vielen weiteren Kosten.

SweetOhm

Commander

- Registriert

- Juli 2023

- Beiträge

- 2.583

Da zahle ich lieber 100 € für das Game OHNE 50xx Karte !Mrbrill schrieb:Es gibt Doom TDA bei verschiedenen Händlern mit dazu, wenn man eine nvidia RTX 50xx Karte kauft.

Ergänzung ()

Weil sie auch keines brauchen/wollen ! Dafür mehr Geld für den Urlaub (Real Life) ...ElliotAlderson schrieb:Abgesehen davon haben AMD User gar kein Reflex.

Ergänzung ()

Und wenn die FPS nicht reichen und schaltet MFG hinzu, erhöht sich die Latenz und Grund FPS werden weniger ...Taxxor schrieb:Man hat als Spieler also die freie Auswahl, mehr FPS bei etwas niedrigerer Latenz oder gleiche FPS bei viel niedrigerer Latenz.

Das berüchtigte „mehr FPS bei höherer Latenz“ gibts nur, wenn man es nicht vom Ausgangszustand aus vergleicht und der ist nun mal weder FG noch Reflex aktiv

Ergänzung ()

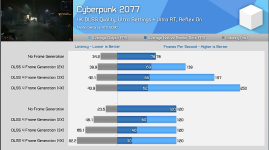

Tut sie (siehe Anhang).ElliotAlderson schrieb:aber FG "verdoppelt" die Bildrate ohne die Latenz signifikant zu verschlechtern.

Anhänge

Zuletzt bearbeitet:

„This is not a key. The game will be gifted to you via the Battle.net system. You will need to provide your BattleTag in order to receive this product.“ThirdLife schrieb:@AYAlf In Keystores ab 44€ zu haben.

Also eventuell mit gestohlenen Kreditkarten gekauft und dann verschenkt. Solche Keys kann man entzogen bekommen. Das wäre mir zu unsicher.

Zuletzt bearbeitet:

SweetOhm

Commander

- Registriert

- Juli 2023

- Beiträge

- 2.583

Eher kann sein, dass Du mit Deiner Exklusiv Meinung der Minderheit angehörstElliotAlderson schrieb:und User wie du haben einfach realitätsfremde Ansprüche, die physikalisch nicht erfüllbar sind? Kann das vielleicht sein?

Doch ! Einfach die Scheuklappen weiter öffnen und Berichte/NEWS im Internet dazu lesen.ElliotAlderson schrieb:Wenn man KI/Datacenter rausnimmt, trifft das nicht zu, also nein.

Ja ich weiß, alles "Cherry/Fake" ...

Ergänzung ()

Hab es auch genau so gelesen/verstanden (wie es ja auch geschrieben war).Czk666 schrieb:Bist du gut drauf? 1. Sorry, ich dachte du meinst es gibt von AMD allgemein keine Alternative und nicht auf das Spiel bezogen.

Aber er "versteht" auch alles anders, wie geschrieben/gemeint wurde.

Zuletzt bearbeitet:

HerrRossi schrieb:Komischerweise kann man es für die Konsolen aber so hinbekommen, dass es flüssig läuft und hübsch aussieht. Beim PC braucht man dann schon mindestens die 500 EUR Grafikkarte...

Kann man nicht verallgemeinern.

Bin mal gespannt, ob Digital Foundry hier wieder vergleichen. Indiana Jones läuft selbst z.B. auf der PS5 Pro u.a. mit einer einfacheren globalen Beleuchtung, als man es mit dem Setting am PC auf "low" hinbekommt, die globale Beleuchtung wurde nämlich von der Xbox übernommen. Ich finde deren Ansatz sowieso oft spannender als einen reinen Benchmark: Welche Specs reichen, um etwa in Konsolenqualität zu zocken bzw. sind die Minimumspecs am PC mit dem Basis-PS5-Erlebnis vergleichbar? Ein kompletter PC als reines Spielgerät wird IMMER teurer sein als eine Konsole. Trotzdem immer sehr interessant.

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

Indy kann man auf einer 3060 oder 4060 zuminest in 1080p spielen, ohne Upscaler hinzuzuschalten und alles auf low zu stellen. (Mit geht auch 1440p). Der Schlüssel ist hier, wie oft erwähnt, die richtige Texturpool-Einstellung (ein STREAMINGCACHE, der grundsätzlich auch auf niedrigen Einstellungen die bestmöglichen Texturen anzeigt, bloß nicht durchgehend -- der Mehrwert ab "high", dem drittniedrigsten Setting, wird zunehmend magerer). Zum Glück haben Machine Games dieses Setting auf Steam Deck gelockt mit einem eigenen Steam-Deck-Setting, k.A. warum man das überhaupt tweaken kann statt eine Autoerkennung einzubauen. Da gibts nur Probleme, wie man hier auch bei CB sieht mit unter 25 fps (!) Lows auf einer RTX 3080, 1080p, Jesus. Und im späteren Spielverlauf: Crashes.

Pathtracing ist was anderes -- aber das ist ja zu erwarten.

Zuletzt bearbeitet:

Addiere einfach zusätzlich noch die folgenden Dinge: Entwicklung, Marketing, Gehälter, Mieten, Energie, Steuern, etc.ThirdLife schrieb:Mach ne bessere auf

Und dann hast du in etwa die Gesamtkosten, von denen du dann die Marge bestimmen kannst.

Oh, wait? Du kennst die Werte oben alle nicht? Das ist natürlich blöd - vor allem wenn man dann über die Preise und das "gierige" NV in irgendwelchen Foren poltert.

Hauptsache man hat erst mal Stammtischmäßig seinen unqualifizierten Mumpitz losgelassen.

Ergänzung ()

So Aussagen kann man sich kaum ausdenken 😂RAZORLIGHT schrieb:Dazu noch die katastrophalen Treiber der letzten Zeit die sicher auf von KI geschrieben wurden.

Hauptsache die eigenen Feindbilder kommen einem nicht abhanden 😁SweetOhm schrieb:Da zahle ich lieber 100 € für das Game OHNE 50xx Karte

Hmm, ich habe genügend für neue Hardware UND Urlaub - muss weder beim einen, noch anderen sparen. Und nu?SweetOhm schrieb:Weil sie auch keines brauchen/wollen ! Dafür mehr Geld für den Urlaub (Real Life) ..

Falsches Spiel 😉SweetOhm schrieb:Tut sie

Weder exklusiv aber vielleicht die Minderheit, ja.SweetOhm schrieb:Eher kann sein, dass Du mit Deiner Exklusiv Meinung der Minderheit angehörst

Aber wenn die Geschichte uns eins gelehrt hat: Die Mehrheit hat nicht immer recht ☝️

Gerade bei so Themen, wo der Stammtischlevel extrem hoch ist und die "Mehrheit" eigentlich keine wirkliche Ahnung hat, wovon sie spricht.

Trotz Technikforum ist die Mehrheit hier nämlich leider in vielen Dingen im absoluten Blindflug unterwegs.

Wenn du es weißt, wieso postest du dann weiterhin Falschinformationen? 😉SweetOhm schrieb:Ja ich weiß, alles "Cherry/Fake" ...

Zuletzt bearbeitet:

SweetOhm

Commander

- Registriert

- Juli 2023

- Beiträge

- 2.583

Yup, sieht man immer bei der tollen Steam GPU AnteilslisteLoopman schrieb:Aber wenn die Geschichte uns eins gelehrt hat: Die Mehrheit hat nicht immer recht ☝️

@SweetOhm Ich will jetzt nicht unken, aber: Die meisten Games kann man durchaus zocken mit den aktuellen Steam-Darlings, siehe Indiana Jones oben. Und das zu einem Bruchteil des Investments in aktuelle Midrange-GPUs. Zumindest in der aktuellen Situation wäre es eine Diskussion wert, wer hier cleverer agiert: die Masse. Oder der Enthusiast.

Ich meine: Wir sind halt nahe am Ende einer aktuellen Konsolen-Generation. Deren Hardware matcht man entsprechend auch in etwa mit aktueller Einstiegs-PC-Hardware. Und PC-Exclusives sind nach dem Heldentod von Wing Commander und Co. noch bedrohter als 8GB VRAM. Bin schon gespannt, wie die PS6 überhaupt aussehen wird -- der Chipmarkt hinterlässt auch hier seine Spuren. Siehe Preis der PS5 Pro, keinerlei substanzielle Preissenkungen mehr für die PS5 -- PreisERHÖHUNGEN neulich für die Xboxen -- und eine Switch 2 für 500 Tacken...

Ich meine: Wir sind halt nahe am Ende einer aktuellen Konsolen-Generation. Deren Hardware matcht man entsprechend auch in etwa mit aktueller Einstiegs-PC-Hardware. Und PC-Exclusives sind nach dem Heldentod von Wing Commander und Co. noch bedrohter als 8GB VRAM. Bin schon gespannt, wie die PS6 überhaupt aussehen wird -- der Chipmarkt hinterlässt auch hier seine Spuren. Siehe Preis der PS5 Pro, keinerlei substanzielle Preissenkungen mehr für die PS5 -- PreisERHÖHUNGEN neulich für die Xboxen -- und eine Switch 2 für 500 Tacken...

Zuletzt bearbeitet:

- Registriert

- Mai 2011

- Beiträge

- 22.646

Nein, das ist doch genau das was ich geschrieben habe. In deinem Anhang wird mit Reflex On auch ohne FG verglichen.SweetOhm schrieb:Und wenn die FPS nicht reichen und schaltet MFG hinzu, erhöht sich die Latenz und Grund FPS werden weniger ...(siehe Anhang)

Im Vergleich zu alles Aus sinkt aber die Latenz und die Bildrate steigt

Ergänzung ()

Im oberen Fall hätte man ohne FG und ohne Reflex 78 FPS bei ~50-55ms.SweetOhm schrieb:Tut sie (siehe Anhang).

Im unteren Fall wird FG dann zusätzlich noch dadurch limitiert, dass man ein 120FPS Limit gesetzt hat.

Natürlich ist es nicht gut für die Latenz wenn sich die Grund FPS dadurch von 120 auf 30 verringern.

Das ist ein Sonderfall in dem es nur ums Stromsparen geht. Ohne das Limit würden sie aber Richtung 360+ gehen mit Grund FPS von 80+ und die Latenz wäre niedriger als bei 120FPS OHNE Reflex

Zuletzt bearbeitet:

- Registriert

- Nov. 2002

- Beiträge

- 9.543

Keine Sorge, Jan hat den teaser geändert - ich vermute mal, meiner war ihm zu dunkel, jetzt gibts das krasse GegenteilDJMadMax schrieb:@Wolfgang

Hat sich das Titelbild auf der Startseite wie von Zauberhand geändert? Das war doch vorher nicht so eine grelle Explosion, oder?! Ich frag nur, weil ich sonst an meinem Verstand zweifle

Das ist eine gute Frage...das sollte so natürlich nicht sein.HerrRossi schrieb:Warum steht der Thread eigentlich unter "Foren - Betriebssysteme - macOS und Mac-Apps"?

Taxxor schrieb:Nein, das ist doch genau das was ich geschrieben habe. In deinem Anhang wird mit Reflex On auch ohne FG verglichen.

Im Vergleich zu alles Aus sinkt aber die Latenz und die Bildrate steigt

Zum einen das.

Zum anderen, vergleiche mal die Latenzen von AMD und Nvidia,

Die 5070ti hat bei 2xFG mit 106 FPS (53 FPS als basis) BESSERE Latenzen als die 9070 XT OHNE Frame gen bei 73 FPS.

Und das obwohl die 5070ti selbst ohne FG schon 11% langsamer als die 9070 XT ist und mit aktivier FG weiter performance verliert (FG kostet ja Leistung) und die Latenzen erhöht werden. Und trotzdem hat die langsamere Nvidia Karte am Ende mit FG die besseren Latenzen, als die schnellere AMD Karte ohne FG.

Würde man zwei in diesem Spiel gleich schnelle Karten vergleichen, wäre der Vorteil für Nvidia noch größer.

Leute die wegen der Latenz FG nicht nutzen wollen kann man bei diesen Daten einfach nicht mehr ernst nehmen. Es ist ja richtig, dass mit Reflex ohne FG nochmals bessere Latenzen möglich sind, da wird AMD dann völlig abgehängt. Aber wenn man dann selbst mit FG immer noch bessere Latenzen hat, dann wird FG doch zum absoluten nobrainer. Zumindest für Nvidia Karten.

HerrRossi

Fleet Admiral

- Registriert

- Apr. 2014

- Beiträge

- 13.045

Volles Echtzeit-Raytracing ist nach wie vor wesentlich zu fordernd für aktuelle Grafikkarten, zB. ohne den AI-Denoiser ginge rein gar nichts. Das alles ist von "native" weit entfernt und deswegen gibt es auch keinen "Fotorealismus", erst recht nicht in flüssigen 60fps.SweetOhm schrieb:Eher kann sein, dass Du mit Deiner Exklusiv Meinung der Minderheit angehörst

Jensen und seine Marketingabteilung haben aber ins Schwarze getroffen, von jetzt auf gleich wurde ein neuer Hype kreiert, der ganz neue Grafikkarten nötig machte und für den die Leute bereit sind, viel mehr Geld auf den Tresen zu legen. Chapeau.

Nur blöd, dass die gleichen Grafikkarten bzw. Chips auch den AI-Hype in den Rechenzentren befeuern und so die Grafikkarten noch teurer werden, was unser Hobby noch exklusiver macht.

Ergänzung ()

Warum baut man solche Settings denn nicht ins PC Spiel ein? Warum kann man bei Doom RT nicht abschalten? Mir könnte es mit meiner 4090 ja egal sein und ich spiele Doom sowieso nicht mehr, aber ich denke eben auch an die Leute, die unser Hobby teilen, aber nicht so viel Geld ausgeben können oder wollen.Svennc schrieb:Indiana Jones läuft selbst z.B. auf der PS5 Pro u.a. mit einer einfacheren globalen Beleuchtung, als man es mit dem Setting am PC auf "low" hinbekommt, die globale Beleuchtung wurde nämlich von der Xbox übernommen.

Aber vllt. ist die Konsole ja auch der bessere Weg, durch die teuren Spiele kommt sowas wie ein Pile of Shame gar nicht erst auf, ich habe noch massig Spiele auf Halde liegen, die ich immer noch nicht gezockt habe, Steam- und anderen Sales sei Dank, Epic hat so viele Games verschenkt, da hab ich nur ein paar Spiele gekauft, der Rest war kostenlos.

Danke für das Video gucke ich gleich rein.

Ergänzung ()

Siehe wie vor: die Grafikkarten sind dafür noch viel zu schwach. Wären wir an einem Punkt, wo das auch Budgetkarten könnten, wäre die Spieleentwicklung auch einfacher, dann könnte man auch ohne KI-Krücken komplett auf Raytracing setzen.Svennc schrieb:Pathtracing ist was anderes -- aber das ist ja zu erwarten.

Zuletzt bearbeitet:

KuroSamurai117

Lt. Commander

- Registriert

- Aug. 2016

- Beiträge

- 1.372

Xbox hat später einen Patch erhalten und das Setting etwas höher gedreht als zu Anfang. Nur was bringt es dem Casual PC Gamer dann wenn er nicht unter Low einstellen kann und es dann auf seiner unter 500,- Karten dann nicht sauber läuft?Svennc schrieb:Kann man nicht verallgemeinern.

Bin mal gespannt, ob Digital Foundry hier wieder vergleichen. Indiana Jones läuft selbst z.B. auf der PS5 Pro u.a. mit einer einfacheren globalen Beleuchtung, als man es mit dem Setting am PC auf "low" hinbekommt, die globale Beleuchtung wurde nämlich von der Xbox übernommen.

Nicht Jeder beherrscht es in der ini-Datei rumzufummeln. Wer es zudem im Game Pass zockt hat es noch schwieriger da auf die Spieldatei zuzugreifen.

Letzten Endes zockst dann auf Konsole doch gleich los nur weil der Entwickler nicht die gleichen Optionen von Anfang an in der PC Version einbaut.

Ist kein Geheimnis dass es immer Zusammenspiel von Software und Hardware darauf an kommt. Nennt man halt Optimierung.

HerrRossi schrieb:Siehe wie vor: die Grafikkarten sind dafür noch viel zu schwach. Wären wir an einem Punkt, wo das auch Budgetkarten könnten, wäre die Spieleentwicklung auch einfacher, dann könnte man auch ohne KI-Krücken komplett auf Raytracing setzen.

Nö, sind nicht zu schwach.

Also theoretisch ja. Um Pathtracing so wie bei offline CGI durchzuführen, würden wir wahrscheinlich noch weitere 50, wenn nicht 100 Jahre warten müssen, bis GPUs das in echtzeit schaffen, weil man irrsinnig viele Rays bzw. Samples braucht.

Mit den aktuell genutzten techniken kommt man aber bereits jetzt extrem nahe an ground truth heran.

Siehe hier: https://research.nvidia.com/labs/adlr/DLSS4/

To start, we highlight the transformer model's ability to produce outputs that are remarkably close to the reference ground truth images, which are rendered using tens of thousands of samples per pixel. This fidelity ensures that the transformer model's output is less painterly and significantly more faithful to the path-traced reference obtained through pure accumulation. The following image comparison illustrates this closeness to the reference image in a static scene, the left side of the swiper is ray reconstruction output while the right side is ground truth:

Ground truth reference:

DLSS Ray Reconstruction:

Natürlich gilt das noch nicht für alles, wie z.B. hochkomplexe Materialien. Aber dafür wird es dann eben die Neural materials und weitere neural shader geben.

Auf konventionellem Wege wäre Pathtracing sonst niemals zu unseren Lebzeiten realisierbar. Man braucht diese Abkürzungen über Machine Learning und co... Die samplerate so wie im Referenzbild auf "tens of thousands of samples per pixel" zu erhöhen ist jedenfalls völliger nonsense. Das wäre das, was auf konventionellem wege nötig wäre. Wie das zweite Bild aber zeigt, geht es auch anders.

Ich denke, spätestens wenn RTXDI (jede lichtquelle ist raytraced, nicht nur die golbale) mit neural Radiance Cache kombiniert wird (quasi KI bounce light), wird das zusammen mit Ray Reconstruction (was nicht nur das denoising verbessert, sondern auch den Detailgrad des Pathtracings deutlich erhöht) wahrscheinlich schon zu 95% perfekt sein und von einem referenz render nicht mehr unterscheidbar sein. Dass es Spielegrafik ist wird man dann nicht mehr an der Beleuchtung erkennen, sondern hauptsächlich daran, wie detailliert die Assets und Materialien sind. Letzteres ist auch bei den beiden Bildern oben noch bei weitem nicht gut genug für fotorealismus, da die Assets eben aus AlanWake2 stammen.

Zuletzt bearbeitet:

TheInvisible

Lt. Commander

- Registriert

- Jan. 2022

- Beiträge

- 2.011

Stimmt aber mit dem marketshare überein, kannst ja eine bessere Quelle nennen. Aber bitte nicht "meine Kumpels haben alle Radeon" lolSweetOhm schrieb:Yup, sieht man immer bei der tollen Steam GPU Anteilsliste

Ähnliche Themen

- Antworten

- 236

- Aufrufe

- 12.694

- Antworten

- 172

- Aufrufe

- 7.317

- Antworten

- 3

- Aufrufe

- 720

- Antworten

- 220

- Aufrufe

- 11.955

- Antworten

- 48

- Aufrufe

- 3.849