Samuelz schrieb:VRR-Flicker tritt außerhalb von Ladebildschirmen oder Shader-Compile-Screens praktisch nicht auf. Im eigentlichen Gameplay ist dieses Problem nicht vorhanden.

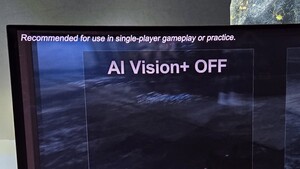

Warum implementiert Asus dann ein peinliches Fake-Anti-Flicker, das VRR selbst in der niedrigsten Einstellung praktisch deaktiviert ?

https://www.reddit.com/r/OLED_Gaming/comments/1cwgk1c/comment/l4x252k/

Und auch wenn Du es nicht siehst - andere schon, und messbar ist es auch:

https://www.rtings.com/monitor/learn/research/vrr-flicker