Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

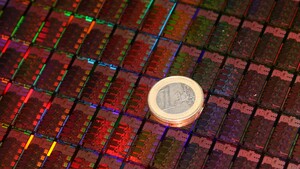

News Core Ultra 300?: Arrow Lake-Refresh soll doch keine schnellere NPU erhalten

- Ersteller Jan

- Erstellt am

- Zur News: Core Ultra 300?: Arrow Lake-Refresh soll doch keine schnellere NPU erhalten

mario_mendel34

Lt. Junior Grade Pro

- Registriert

- März 2010

- Beiträge

- 425

Stimmt, die IPC der Lion Cove-Kerne ist etwas höher als Zen 5. Trotzdem ist der 9800X3D bei Volllast auf 1 Kern durch den höheren Takt minimal schneller und verbraucht dabei auf 1 Kern weniger. Es geht mir hier nicht darum, Intel zu bashen, aber dass eine neue Architektur, die in einem besseren Prozess gefertigt wird als die Konkurrenz, bei in etwa gleicher Performance mehr Strom verbraucht, kann so von den Entwicklern nicht beabsichtigt gewesen sein. Darum ging es mir, es muss irgendetwas schiefgelaufen sein. Und genau das muss Intel fixen, ich glaube nicht, dass das mit einem simplen Refresh geht.ElliotAlderson schrieb:Und? Takt allein sagt nichts aus.

Ich muss zugeben, dass ich den Vergleich mit dem 5800X3D lieber nicht gebracht hätte, weil der total Äpfel mit Birnen ist, ist mehrere Jahre her, anderes Windows-Build, anderer Patchstand des Spiels, andere Grafikkarte, einfach alles ist anders. Habe den 5800X3D halt schon lange nicht mehr und kann ihn nicht nochmal frisch nachbenchen.MalWiederIch schrieb:Du kombinierst eine CPU die zumindest durchschnittlich RAM benötigt mit unterdurchschnittlich langsamem RAM und wunderst dich warum die CPU nicht wie im Computerbase Leistungsrating 16% vor dem 5800X3D liegt?

Muss man wirklich nicht verstehen

160W GPU, ich kombiniere den 265 mit einer RX 9060 XT. Es geht nicht um Stromersparnis, das Mini-ITX-System kommt in ein Fractal Design Node 202, das ist sehr flach und hat nicht viel Platz für Kühler und Airflow. Ich möchte mir einen konsolenartigen PC damit bauen, den ich bei meinen Eltern ins vorhandene Hifi-Rack integrieren kann, damit man auf dem Sofa mal gemütlich auf dem Fernseher ein Steam-Spiel spielen kann. Da kommt schlussendlich auch kein Windows drauf, sondern Bazzite. Ich habe zum 50 € teureren non-K-Modell gegriffen, weil dieses Modell halt ab Werk schon 65 W TDP hat, das K-Modell müsste ich im BIOS erst runterbremsen. Außerdem war ich neugierig, wie der Intel Boxed-Kühler performt. Der performt schlecht, es kommt jetzt trotzdem ein anderer Kühler drauf. Aber ich wollte es halt ausprobieren. Habe ich 50 € verschenkt.MalWiederIch schrieb:Jetzt ist nur noch die Frage warum man überhaupt zum 50€ teureren non-K-Modell greifen sollte? Für die 50€ hätte man auch den 5€ teureren Kühler finanzieren können … 10-15W Differenz bzw. 0,003-0,0045€ Ersparnis die Stunde beim Spielen holen die Differenz von 50€ auch nicht wieder rein … und 10-15W weniger Abwärme? Naja, ob das bei der 300W+ GPU auffällt

Dass ich durch den langsameren RAM in Spielen Performance auf der Straße liegen lasse, war mir bewusst, ich entscheide mich bewusst seit einigen Jahren nur für JEDEC-konformen Speicher, weil ich mit XMP eine lange Leidensgeschichte habe. Kann sein, dass ich immer Pech bei der Mainboard-, IMC-, Speicher-IC-Lotterie hatte, ich habe einfach keine Lust mehr auf Instabilitäten und kaufe daher immer den höchsten zugelassenen Takt als JEDEC-Kit. Auch darum ging es mir nicht. Der Durchlauf von @BernmanHH war wegen besserem RAM im erwartbaren Rahmen schneller, aber auch sein Ergebnis ist für dieses Spiel unterdurchschnittlich. Ich habe aber auch gestern schon geschrieben, dass das wahrscheinlich ein Ausrutscher nach unten ist, und so ist es auch. Ich habe inzwischen ein paar andere Spiele angetestet, und da performt der 265 besser, trotz langsamem JEDEC-RAM. Es war Cherry Picking, aber kein bewusstes, ich habe dieses Spiel vor dem Schlafen gehen halt schnell noch angeschmissen, weil der Ingame-Benchmark halt so schöne Statistiken ausspuckt.MalWiederIch schrieb:Was eine Überraschung - bei @mario_mendel34 sitzt das Problem vor dem Bildschirm und gleich wurde wieder wie üblich alles auf die Hardware geschoben

Ich habe mir das Arrow-Lake-System auch nicht gekauft, um darüber abzulästern, sondern bewusst wegen dem geringen Idle-Verbrauch, und das klappt auch, 41 W trotz dGPU. Das wäre so mit AM5 niemals im Leben möglich gewesen. Ich wollte einfach nur mal meine ersten Eindrücke teilen.

Zuletzt bearbeitet:

RealMax123

Lieutenant

- Registriert

- Mai 2025

- Beiträge

- 627

Intressiere mich auch für Mini-ITX aber die Kombination mit der Radeon RX 9060 XT wundert mich schon sehr und noch mehr bei einem Mini-ITX.mario_mendel34 schrieb:160W GPU, ich kombiniere den 265 mit einer RX 9060 XT. Es geht nicht um Stromersparnis, das Mini-ITX-System kommt in ein Fractal Design Node 202, das ist sehr flach und hat nicht viel Platz für Kühler und Airflow. Ich möchte mir einen konsolenartigen PC damit bauen, den ich bei meinen Eltern ins vorhandene Hifi-Rack integrieren kann, damit man auf dem Sofa mal gemütlich auf dem Fernseher ein Steam-Spiel spielen kann. Da kommt schlussendlich auch kein Windows drauf, sondern Bazzite. Ich habe zum 50 € teureren non-K-Modell gegriffen, weil dieses Modell halt ab Werk schon 65 W TDP hat, das K-Modell müsste ich im BIOS erst runterbremsen. Außerdem war ich neugierig, wie der Intel Boxed-Kühler performt. Der performt schlecht, es kommt jetzt trotzdem ein anderer Kühler drauf. Aber ich wollte es halt ausprobieren. Habe ich 50 € verschenkt.

Bei den Radeon finde ich vorallem die RX 7700 XT und RX 7800 XT für klassische ATX und µATX Tower intressant, weil man da für verhälnismässig wenig Geld verhältnissmässig viel Leistung bekommt.

Die RX 9060 XT ist aber doch deutlich grösser als eine GeForce RTX 5060 oder 5060 Ti aber schwächer als eine 5060 Ti, und nur minimal günstiger. Von der Grösse her sind selbst einzelne RTX 5070 kleiner.

mario_mendel34

Lt. Junior Grade Pro

- Registriert

- März 2010

- Beiträge

- 425

@RealMax123 Nvidia fällt für meinen Einsatz unter Bazzite (eine Linux-Gaming-Distro) leider flach, weil die Gamescope-Session damit leider gar nicht funktioniert. Damit könnte ich höchstens auf dem Desktop zocken, was sich aber vom Sofa aus mit Controller am Fernseher wieder blöd bedienen lässt. Das ganze soll sich halt anfühlen wie eine Konsole, nicht wie ein PC. Quasi ein Steam Deck mit mehr Rechenleistung. Das geht aktuell vollumfänglich nur mit AMD-Grafikkarten, und die RX 9060 XT ist bei RDNA4 die einzige, die ins Node 202 passt.

ElliotAlderson

Commander

- Registriert

- Juni 2024

- Beiträge

- 2.214

Spiele profitieren stark vom X3D Cache, den Intel nicht hat. Ist jetzt keine neue Erkenntnis.mario_mendel34 schrieb:Stimmt, die IPC der Lion Cove-Kerne ist etwas höher als Zen 5. Trotzdem ist der 9800X3D bei Volllast auf 1 Kern durch den höheren Takt minimal schneller und verbraucht dabei auf 1 Kern weniger. Es geht mir hier nicht darum, Intel zu bashen, aber dass eine neue Architektur, die in einem besseren Prozess gefertigt wird als die Konkurrenz, bei in etwa gleicher Performance mehr Strom verbraucht, kann so von den Entwicklern nicht beabsichtigt gewesen sein. Darum ging es mir, es muss irgendetwas schiefgelaufen sein. Und genau das muss Intel fixen, ich glaube nicht, dass das mit einem simplen Refresh geht.

mario_mendel34

Lt. Junior Grade Pro

- Registriert

- März 2010

- Beiträge

- 425

@ElliotAlderson Alles, was ich zu 1-Kern-Volllast schrieb, bezog sich nicht auf Spiele, sondern auf Cinebench Single Core. Da ist der 3D-Cache komplett egal. Alle Zen-5-CPUs liefern hier bei gleichem Takt gleiche Performance.

Ausprobieren mit dem Threadripper, habe aber meine Zweifel, viele Kerne hin oder her.Tech-Dino schrieb:Bräuchte dringend mal eine CPU für den Microsoft Flight Simulator 2024.

BTW: auch mein 9800X3D kann ich auf 35FPS drücken, einfach MK Studios LSZH mit fast ultra Settings und AI Traffic von AIG (75% Einstellung) laufen lassen und zack, FPS iwo zwischen 33-36. Dank Frame Generation trotzdem noch OK, aber weit weg von perfekt. Ist aber halt auch mein absolutes Extremtestszenario (warum auch immer, grössere Airports laufen lustigerweise besser).

- Registriert

- Apr. 2001

- Beiträge

- 17.460

Artikel-Update: Meldungen, Arrow Lake-Refresh könnte neben höheren Taktraten auch eine schnellere NPU erhalten, sollen sich am Ende doch nicht bewahrheiten. Das Gerücht, das schon im letzten Jahr aufkam und in der letzten Woche neu aufgeflammt war, wird von X-Nutzer Jaykihn kassiert.

[Embed: Zum Betrachten bitte den Artikel aufrufen.]

Wenn man ehrlich ist hat die NPU bisher nicht wirklich den Mehrwert den ein dezidierter block auf dem chip eigentlich verdient hätte ^^

Wenn da nicht bald was kommt sehe ich das alles wieder als FP8/16 Block zurück in die angepasste iGPU wandern und fertig.

Wenn man tatsächlich die Leistung braucht helfen CPU und GPU sowieso mit

Wenn da nicht bald was kommt sehe ich das alles wieder als FP8/16 Block zurück in die angepasste iGPU wandern und fertig.

Wenn man tatsächlich die Leistung braucht helfen CPU und GPU sowieso mit

Botcruscher

Commodore

- Registriert

- Aug. 2005

- Beiträge

- 4.924

Tja, wie beschrieben wirtschaftlich kompletter Unfug. Der Nutzen der Siliziumverschwendung beschränkt sich aktuell auf KI Blur, der Erkennung von Katzenbildern im NAS (Minimal Sinnvoll) und einen Sticker von MS für eine KI die keiner haben will (Recall lol).

Was soll von Intel auch kommen? Der Chip leidet fundamental unter der verschlechterten Latenz. Da was zu ändern würde ein komplett neues Silizium mit massiven Anpassung der Architektur erfordern.

PS: Vielleicht sollte MS es mal mit einer einheitlichen Schnittstelle probieren. So eine Art Direkt AI...

Was soll von Intel auch kommen? Der Chip leidet fundamental unter der verschlechterten Latenz. Da was zu ändern würde ein komplett neues Silizium mit massiven Anpassung der Architektur erfordern.

PS: Vielleicht sollte MS es mal mit einer einheitlichen Schnittstelle probieren. So eine Art Direkt AI...

Seinfeldfreak

Lt. Junior Grade

- Registriert

- Jan. 2003

- Beiträge

- 491

Verstehe ich auch nicht. Habe mir im Mai einen neuen PC mit einem 265k zusammengestellt. Preislich gab es von AMD zu dem Zeitpunkt keine Alternative, die da mithalten konnte, gerade was Anwendungsperformance angeht. Die CPU läuft ohne Probleme und genau das will ich ja. Ob da nun der Sockel wieder abgelöst wird, interessiert micht nicht, da ich eine Plattform meist 5-7 Jahre nutze und dann kommt wieder was Neues. Das letzte Mal, als ich auf einem Board eine CPU getauscht hatte, ist bestimmt schon 15 Jahre her.ueg schrieb:Warum hassen hier eigentlich alle die Core Ultra 200er Reihe so sehr?

Das sind doch ziemlich effiziente schnelle CPUs die nicht mal besonders teuer sind.

Außer den x3d CPUs macht doch amd nichts wirklich besser.

Ich brauche auch keine npu, aber ich finde Intel ist mit dem Blick auf effizientere CPUs wie zb dem 265k auf dem richtigen Weg…

unbekannter1000

Cadet 4th Year

- Registriert

- Juli 2007

- Beiträge

- 69

Die aktuelle Meldung passt eigentlich dazu, was ich mir leider schon dachte. Es wird kaum Geld oder Ressourcen investiert, sondern nur eine Selektion der Chips gemacht. Dadurch kann man einen etwas höher getakteten Chip anbieten. Intel geht es wirklich schlecht und sie haben im Moment absolut keine großen Möglichkeiten, da sie den Zug verpasst habe.

mario_mendel34

Lt. Junior Grade Pro

- Registriert

- März 2010

- Beiträge

- 425

Die Performance von Arrow Lake ist halt extrem wechselhaft, manchmal richtig gut, und manchmal richtig schlecht. In Yooka Laylee musste ich die E-Kerne abschalten, weil ich sonst bei 90 FPS im CPU-Limit war. Ein Problem, was eigentlich in der Vorgängergeneration schon gelöst war. Da klemmt irgendwas im Design der CPU mächtig, wie die erste Ryzen-Generation, die teilweise ja auch richtig schlecht war.Seinfeldfreak schrieb:Verstehe ich auch nicht.

- Registriert

- Okt. 2023

- Beiträge

- 4.497

Die Sinnhaftigkeit irgendwelche Gerüchte von X Nutzern zu diskutieren ist sowieso vakant.stefan92x schrieb:Also wird es noch langweiliger als eh schon und die ganze Diskussion um die Sinnhaftigkeit der NPU hier im Thread war sinnlos

Man kann froh sein, dass CB nicht auf die 7GHz Gerüchte von Zen 6 aufgesprungen ist.

KI Anwendungen lassen sich auch ohne NPU lokal ausreichend schnell beschleunigen, von daher ist das sowieso erstmal nur für einen Sticker und Geräte ohne dedizierte GPU wie den 285H relevant.

Man hat die Auswirkungen der Latenz durch das Chhipletdesign doch ziemlich gut im Griff, wenn man mit Zen 5 vergleicht. Sehe nicht wie du darauf kommst, dass dies ein Problem sei.Botcruscher schrieb:Der Chip leidet fundamental unter der verschlechterten Latenz.

In einem Jump and Run Spiel aus 2017, das auf einer Kartoffel, sprich einem Phenom II X6 mit 100 FPS läuft? Ok.mario_mendel34 schrieb:In Yooka Laylee musste ich die E-Kerne abschalten, weil ich sonst bei 90 FPS im CPU-Limit war.

Zuletzt bearbeitet:

NoNameNoHonor

Lt. Commander

- Registriert

- Nov. 2020

- Beiträge

- 1.052

Vielleicht - man soll die Hoffnung nicht aufgeben - senkt Intel ja nochmal die Preise, dann hole ich mir tatsächlich auch einen 265K, über alles gesehen (also nicht nur Spiele sondern auch in Anwendungen) ist der m.E. doch als ausgewogen zu nennen, und ist damit bemerkbar schneller als ein 9700X, der momentan genauso viel kostet.

CrimsoN3.0

Lieutenant Pro

- Registriert

- Jan. 2021

- Beiträge

- 723

Und AMD gerade so: Nice noch mal ein Jahre mehr Umsatz und Gewinn für uns ^^

Xedos99

Captain

- Registriert

- Aug. 2007

- Beiträge

- 3.202

Höher getaktet ist mir erstmal Wurst.Wäre nicht schlecht, wenn die TDP wieder auf Ultra 200 S - Einstiegsnivau fallen würde. Aber das wird wohl bei der sich andeutenden Brutforce Atacke nicht passieren.

Als 4k Zocker ist mir der CPU Hersteller aktuell auch erstmal egal. Wegen 2-5 FPS mehr, würde ich jetzt nicht unbedingt auf Ryzen 9000x3d wechseln.

Als 4k Zocker ist mir der CPU Hersteller aktuell auch erstmal egal. Wegen 2-5 FPS mehr, würde ich jetzt nicht unbedingt auf Ryzen 9000x3d wechseln.

Ähnliche Themen

- Antworten

- 47

- Aufrufe

- 3.827

- Antworten

- 17

- Aufrufe

- 1.475

- Antworten

- 106

- Aufrufe

- 9.915