Laphonso schrieb:

Nvidia hat es geschafft, dass ich im Kumpel- und Kollegenkreis in den neuen Buildplannern im "klassichen Midrange /Midrange plus" derzeit quasi ausnahmslos die 9070XT empfehle, es sei denn der Spielefokus dreht sich nur um Raytracing und Enthusiastengedöns, bei dem Preisleistung und Stromfress Skill so schlimm sein können, dass man eh die 5090 GPU kauft.

Diesen Monat wird in meinem Gamingzirkel bereits das zweite 9070XT System gekauft, um das zu würdigen.

Dass ich zweimal hintereinander zu Systemen mit AMD GPUs rate, hatte ich zuletzt 2019 oder so mit der 6800XT.

Was AMD vor 2,5 Jahren grandios verkackt (nach meinen Maßstäben) hat mit den enttäuschenden 7900ern GPUs, haben sie mit den 9070ern überkompensiert.

FSR4 hilft hier on top und 9070XT Preise mittlerweile sogar bei 650 Euro ebenso, so dass es den Nvidia 5070Ti Aufpreis nicht mehr rechtfertigt.

Dass sie die Treiberpflege nun besser hinbekommen als Nvidia, ist ein gutes Rundumpaket.

Ich bezweifle zwar, dass Nvidia das Jahr 2025 mit weniger als 85% GPU Marktdominanz im Gamingsegment beendet, aber man kann ja hoffen, dass AMD dieses Jahr GPU Boden gutmacht.

Na ja, die 5070ti kostet ca 120€ mehr und bietet dafür DLSS4, was man mit quasi einem Klick in der Nvidia App in jedem DLSS2+ Spiel nutzen kann.

AMD bietet FSR4 nur in wenigen neuen Spielen an und über 3rd Party Tools wie Optiscaler kann man es zumindest in andere FSR3.1 spiele modden, wenn es funktioniert.

Ansonsten muss man eben FSR3/2 nutzen, was halt z.B. im Performance Modus in 4K extrem schlecht gegenüber DLSS4 performance aussieht. Selbst gegen FSR4 ist DLSS4 im Vorteil, womit man auf Nvidia ein schnelleres Preset bei vergleichbarer Qualität nutzen kann.

Mit DLSS4 kannste dann auch Multi Frame Gen und Smooth Motion nutzen. Dagegen hat AMD z.B. auch nichts zu bieten. Gibt kein MFG und das Treiber AFMF kann auch nicht mit Smooth Motion mithalten. Auch die FSR Frame Generation hat in letzter Zeit Probleme mit dem Framepacing gezeigt (was dann in betroffenen Spielen dazu führt, dass es trotz aktiver FG nicht flüssiger wird)

Nvidia Reflex ist mittlerweile auch in jedem Spiel verfügbar, das DLSS Frame Generation kann. AntiLag2 hingegen nur vereinzelt.

Von so features wie Pathtracing performance und Ray Reconstruction brauchen wir dann gar nicht sprechen, da man eh nicht zu AMD greift, wenn man das nutzen will, ist aber eben auch wieder ein Vorteil für NV.

Wie auch immer, ich erzähl hier ja nix neues, aber selbst wenn man PT/RT komplett ausklammert, ist doch Nvidia alleine beim Featureset extrem weit vorne.

In 4K sind upscaling und auch Frame gen essenziell wenn man ein Display mit 120-240 Hz befeuern will, auch in älteren Spielen, die 3-5 Jahre alt sind.

NV bietet da in hunderten Spielen mit DLSS4 und (M)FG die momentan bestmögliche Bildqualität und performance die man mit den modernen Algorithmen eben rausholen kann, während AMD FSR4 nur in den neuesten Spielen anbietet.

Wer da wegen 120€ zu AMD greift…

Ich finde den Aufpreis bei Nvidia in dem Fall mehr als nur fair. Wobei man die Unterschiede mit dem Preis eh nicht kompensieren kann. Selbst wenn die AMD Karte nur die hälfte kosten würde, muss ich ja trotzdem mit den Nachteilen Leben, die je nach setup eben absolut maßgeblich für Bildqualität und Performance sind (also die beiden Hauptaspekte weshalb man überhaupt eine neue GPU kauft) Ist ja auch völlig unabhängig des Modells und der Preisklasse ein Nachteil bei AMD.

AMD hat mit der 9000 Serie stark aufgeholt und FSR4 ist ne super Sache. Aber die Gründe zu AMD zu greifen sind doch noch geringer als beim letzten mal. Da hatte AMD wenigstens noch durch die Bank mit mehr VRAM gepunktet. Der Pluspunkt ist diesmal zumindest bei der 9070XT bzw. der Nvidia Konkurrenz in Form der 5070ti hinfällig.

Als Käufer muss man sich ja auch die Frage stellen, was bietet die AMD Karte, was Nvidia nicht hat, was macht sie besser. Bis auf den Preis fällt mir da nichts ein.

Robin77 schrieb:

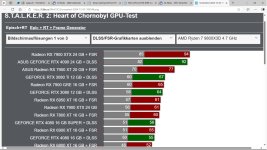

Das 1440p Ergebnis von Hardwareunboxed passt halt irgendwie überhaupt nicht zu dem was Computerbase hier berechnet hätte, wo die 9700XT 3% hinter der 5070TI landen würde statt 3% vorne. Eine Diskrepanz von 6% ist schon auffällig…

Daran ist mal überhaupt gar nichts auffällig. Dir ist wohl nicht bewusst, dass wir bei AMD und Nvidia von zwei völlig verschiedenen Architekturen zweier verschiedener Hersteller sprechen. Die Chiparchitekturen haben logischerweise ihre stärken immer in leicht unterschiedlichen Bereichen, was ganz automatisch dazu führt, dass der Performance-Abstand je nach Spielszene ziemlich stark schwanken kann.

Digital Foundry hat immer recht häufig in ihren Vidoes den FPS Verlauf der GPUs in der Testszene übereinander gelegt und da hat man immer gut gesehen, wie zwei gleich schnelle AMD/NV Karten von Szene zu Szene völlig unterschiedlich performen. In einem Bereich ist vielleicht Nvidia 5% vorne, in einer anderen Szene ist AMD 5% vorne. Die Abstände variieren durchgehend und können sich häufig auch komplett drehen.

Es ist daher totaler quatsch davon auszugehen, dass das Ergebnis von HUB „nicht passt“. Die nutzen eben andere Spiele und andere Benchmarkszenen. Völlig normal, dass dann auch völlig andere Ergebnisse zustande kommen oder sich sogar die Positionierung von Karten im Performance chart dreht.

Das liegt in der Natur der Sache, wenn man GPUs (oder such CPUs) mit unterschiedlichen Architekturen in unterschiedlichen Testszenen testet.

Praktisch könnte man also nicht nur durch die Wahl der getesteten Spiele, sondern auch durch die Auswahl der Testszene und sogar die Grafiksettings sehr starken Einfluss auf die Benchmarkergebnisse nehmen und so Szenarien finden in denen ein Hersteller sehr viel besser performt, als der andere.

Gerade deswegen ist es so wichtig, sich nicht nur Benchmarks von einer Seite anzusehen. Nicht unbedingt weil versucht wird einen Hersteller zu bevorzugen, sondern weil es nunmal realität ist, dass unterschiedliche Benchmarks zu unterschiedlichen Ergebnissen kommen.

Extremes Beispiel ist z.B. auch PCGH in Pathtracing Benchmarks.

Wenn die mal wieder in 4K mit Quality Upsampling testen, dann ist die GPU Last so enorm hoch (und die FPS auch sehr niedrig) dass zum einen Nvidia, aber insbesondere breite Chips wie die 4090 und 5090 alles andere sehr weit hinter sich lassen.

Nutzt man dann spielbarere Settings wie z.B. Performance Upsampling, was bei Pathtracing eigentlich immer anzuraten ist, dann schrumpfen die Abstände deutlich, obwohl ein CPU Limit in weiter Ferne liegt.

Das ist ein gutes Beispiel, wie man alleine anhand der gewählten Settings schon eine Architektur, in dem Fall sogar einen Chip ganz gezielt in die Karten spielen kann.

Eine RTX5090 hat halt enorm viele Compute units und ein extrem „breites“ design das von Spielen schwer auszulasten ist. Die ganze rohleistung kommt somit in den meisten Spielen oder bei höheren FPS kaum zum tragen. Bei Pathtracing in hohen Auflösungen wird der Chip aber dann aber eben in der Breite viel besser ausgelastet und kann sich so deutlich absetzen. Auch wenn die FPS für die meisten Spieler mit solchen Settings zu niedrig sind, entstehen so eben die längsten Benchmarkbalken bei der 5090.