SavageSkull schrieb:

Du würdest auf echte Frames verzichten?

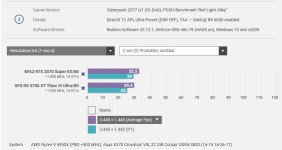

Wir reden hier in den meisten Spielen von 10%, RT/PT eher oder Vorteil GeForce das sind Leistungsbereiche auf diese immer sehr viele verzichten können, solange es sich um eine Nvidia Karte handelt. Natürlich lässt sich dieser objektive Leistungsverlust in RR/Seichten RT Games mit dem besseren Upscaler im Performancemodus, MFG, mehr Reflex, dem ein oder anderen GameBundle bzw. GameSupport oder Remix usw. in den Titeln bestens kaschieren, womit einige dann lieber die GeForce nehmen, während andere auf die 16GB VRAM setzen, weil sie zum Beispiel einen 4K Monitor nutzen.

Es ist wie mit allem so, es ist rein auf die Fakten bezogen eine ziemlich enge Kiste welche Karte bevorzugt wird, das zeigen auch die Retailkäufe bei Amazon. Die 5070 (6000 Units) ist dort weit vor der 9070 (250)

Nur weil wir uns hier ein einer extremen Blase befinden und der unterlegene Marktteilnehmer, mit den insgesamt langsameren GPU Produkten über 50% Marktanteil stellt, während der andere (Intel) bei CPUs nur noch auf 20% kommt und das obwohl er der Marktführer ist.

Also rein faktisch gesehen, ist hier schon ein deutlicher Bias erkennbar.

SavageSkull schrieb:

(Eine 9070 ist schneller als eine 5070) Und das mit Fake Frames ausgleichen wollen?

Die 5070 ist ab 499 Euro erhältlich inkl. Arc Raiders, die Radeon beginnt bei 515 Euro, also grundsätzlich ähnlicher Preis, aber kein Bundle bei der Radeon. Mehr oder weniger 30-40 Euro teurer.

SavageSkull schrieb:

Die Renderzeiten werden nicht besser. Entweder es ist ohne das Feature flüssig oder nicht. MFG macht ein Spiel nicht flüssiger oder schneller.

Multi Frame Generation macht genau das, es macht Spiele flüssiger fürs Auge und kombiniert das mit Reflex, womit die Eingabelatenz in fast allen Fällen niedriger als Nativ ist.

So gesehen in Cronos The New Dawn, Ouer Worlds 2, hier spielt es sich selbst mit einer 5060Ti dank Reflex und MFG wie auf einer 9070XT. Was bringt mir also die Radeon in den Fällen?

Mit DLSS FG geschieht das automatisch. Bei FSR Frame Gen funktioniert das dagegen nicht, hier benötigt es deutlich mehr FPS für ein gutes Spielerlebnis als bei DLSS FG.

Mit der Radeon spielt du somit mit 95ms Latenz + zusätzlich jene aus der Framegenerierung.

MFG macht das Spiel hier wesentlich flüssiger, ohne merkbar die Latenz zu erhöhen.

Was sind denn schon 3ms?

SavageSkull schrieb:

DLSS war auch für mich lange ein relevanter Vorteil. Aber mit FSR4 habe ich die gleiche Qualität endlich auch mit AMD.

Die gleiche Qualität ist das nach wie vor nicht, auch wen DLSS4 teilweise Probleme mit dem UE5 Denoiser und Wasserdarstellung hat. Insgesamt ist DLSS vor allem im Performancemodus insgesamt noch ein gutes Stück besser (Bildstabilität), im Quality Modus ist das vernachlässigbar.

SavageSkull schrieb:

Valve pusht Linux gerade ziemlich stark und Nvidia ist da aufgrund ihres Treibers echt ein Nachteil

Linux ist eine ziemlich schwäche von Nvidia, da stimme ich dir zu.

Mcr-King schrieb:

Das stimmt, und allgemein sind die Treiber bei NV zurzeit eher bescheiden. Außerdem ist der Stromanschluss auch so ein Punkt, bei dem ich mir denke: Nee, lieber nicht.

Die Treiberprobleme sind mittlerweile schon seit gut einem halben Jahr Geschichte, bzw. Stromanschluss ist bei den wenigen Einzelfällen völlig irrelevant. Wenn es danach ginge, darfst du keine aktuelle GPU in irgendein System einbauen.